Правильный robots txt для WordPress сайта – инструкция на 2019-2020 год без плагинов

Для чего нужен robots.txt

Robots.txt создан для регулирования поведения поисковых роботов на сайтах, а именно куда им заходить можно и брать в поиск, а куда нельзя. Лет 10 назад сила данного файла была велика, по его правилам работали все поисковые системы, но сейчас он скорее как рекомендация, чем правило.

Но пока не отменили, вебмастера должны делать его и настраивать правильно исходя из структуры и иерархии сайтов. Отдельная тема это WordPress, потому что CMS содержит множество элементов, которые не нужно сканировать и отдавать в индекс. Разберемся как правильно составить robots.txt

Где лежит файл robots в WordPress

На любом из ресурсов robots.txt должен лежать в корневой папке. В случае с вордпресс, там где находится папка wp-admin и ей подобные.

Расположение на сервере

Расположение на сервере

Если не создавался и не загружался администратором сайта, то по умолчанию на сервере не найти. Стандартная сборка WordPress не предусматривает наличие такого объекта.

Как создать правильный robots txt

Создать правильный robots txt задача не трудная, сложнее прописать в нем правильные директивы. Сначала создадим документ, открываем программу блокнот и нажимаем сохранить как.

Сохраняем документ

Сохраняем документ

В следующем окне задаем название robots, оставляем расширение txt, кодировку ANSI и нажимаем сохранить. Объект появится в папке куда произошло сохранение. Пока документ пустой и ничего не содержит в себе, давайте разберемся какие именно директивы он может поддерживать.

При желании можете сразу скачать его на сервер в корень через программу FileZilla.

Сохранение роботса

Сохранение роботса

Настройка команд

Выделю четыре основные команды:

- User-agent: показывает правила для разных поисковых роботов, либо для всех, либо для отдельных

- Disalow: запрещает доступ

- Allow: разрешаем доступ

- Sitemap: адрес до XML карты

Устаревшие и ненужные конфигурации:

- Host: указывает главное зеркало, стало не нужным, потому что поиск сам определит правильный вариант

- Crawl-delay: ограничивает время на пребывание робота на странице, сейчас сервера мощные и беспокоится о производительности не нужно

- Clean-param: ограничивает загрузку дублирующегося контента, прописать можно, но толку не будет, поисковик проиндексирует все, что есть на сайте и возьмет по–максимому страниц

Рабочий пример инструкций для WordPress

Дело в том что поисковой робот не любит запрещающие директивы, и все равно возьмет в оборот, что ему нужно. Запрет на индексацию должен быть объектов, которые 100% не должны быть в поиске и в базе Яндекса и Гугла. Данный рабочий пример кода помещаем в robots txt.

User-agent: *

Disallow: /wp-

Disallow: /tag/

Disallow: */trackback

Disallow: */page

Disallow: /author/*

Disallow: /template.html

Disallow: /readme.html

Disallow: *?replytocom

Allow: */uploads

Allow: *.js

Allow: *.css

Allow: *.png

Allow: *.gif

Allow: *.jpg

Sitemap: https://ваш домен/sitemap.xmlРазберемся с текстом и посмотрим что именно мы разрешили, а что запретили:

- User-agent, поставили знак *, тем самым сообщив что все поисковые машины должны подчиняться правилам

- Блок с Disallow запрещает к индексу все технические страницы и дубли. обратите внимание что я заблокировал папки начинающиеся на wp-

- Блок Allow разрешает сканировать скрипты, картинки и css файлы, это необходимо для правильного представления проекта в поиске иначе вы получите портянку без оформления

- Sitemap: показывает путь до XML карты сайта, обязательно нужно ее сделать, а так же заменить надпись”ваш домен”

Остальные директивы рекомендую не вносить, после сохранения и внесения правок, загружаем стандартный robots txt в корень WordPress. Для проверки наличия открываем такой адрес https://your-domain/robots.txt, заменяем домен на свой, должно отобразится так.

Адрес в строке запроса

Адрес в строке запроса

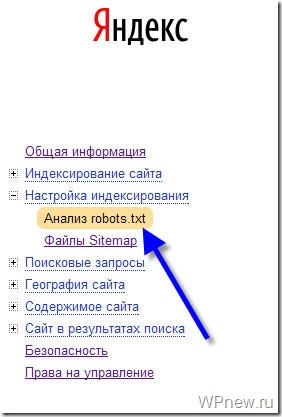

Как проверить работу robots.txt

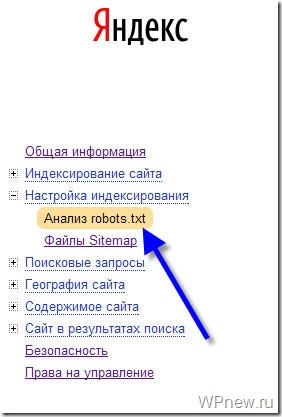

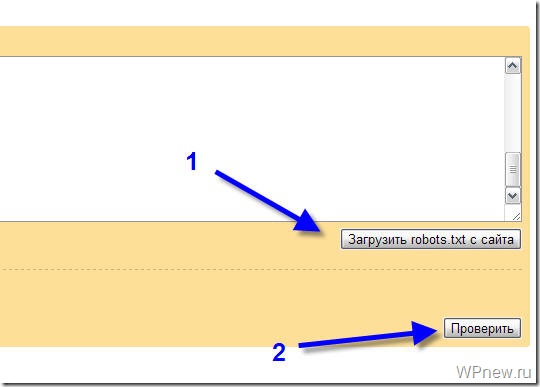

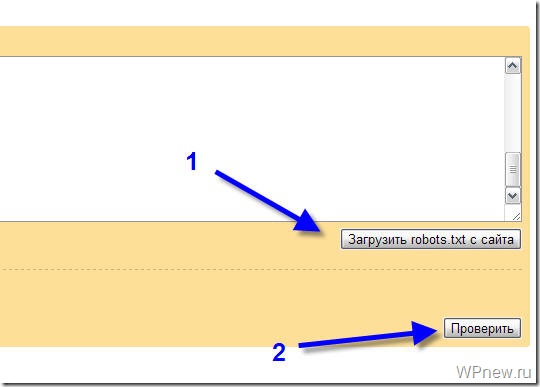

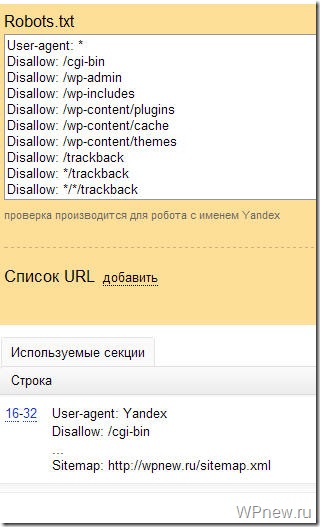

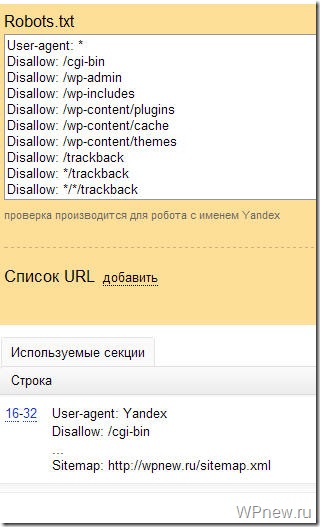

Стандартный способ проверить через сервис yandex webmaster. Для лучшего анализа нужно зарегистрировать и установить на сайт сервис. Вверху видим загрузившийся robots, нажимаем проверить.

Проверка документа в yandex

Проверка документа в yandex

Ниже появится блок с ошибками, если их нет то переходим к следующему шагу, если неверно отображается команда, то исправляем и снова проверяем.

Отсутствие ошибок в валидаторе

Отсутствие ошибок в валидаторе

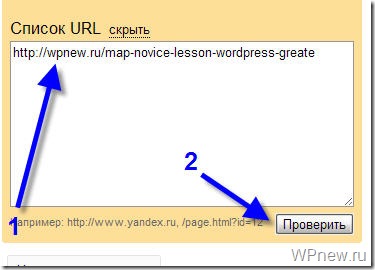

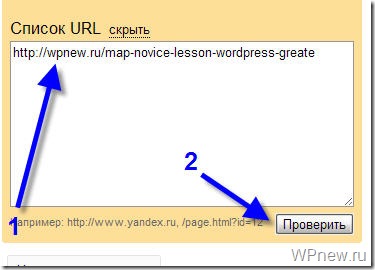

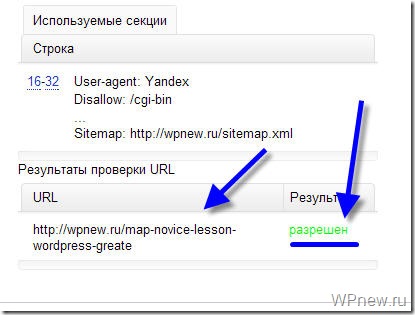

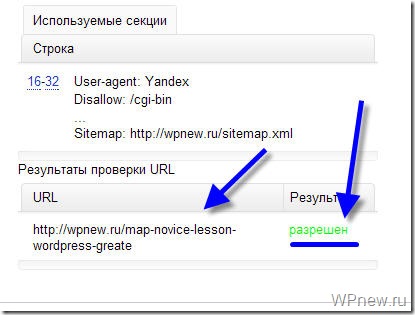

Проверим правильно ли Яндекс обрабатывает команды, спускаемся чуть ниже, введем два запрещенных и разрешенных адреса, не забываем нажать проверить. На снимке видим что инструкция сработала, красным помечено что вход запрещен, а зеленой галочкой, что индексирование записей разрешена.

Проверка папок и страниц в яндексе

Проверка папок и страниц в яндексе

Проверили, все срабатывает, перейдем к следующему способу это настройка robots с помощью плагинов. Если процесс не понятен, то смотрите наше видео.

Плагин–генератор Virtual Robots.txt

Если не хочется связываться с FTP подключением, то приходит на помощь один отличный WordPress плагин–генератор называется Virtual Robots.txt. Устанавливаем стандартно из админки вордпресс поиском или загрузкой архива, выглядит так.

Как выглядит Virtual Robots.txt

Как выглядит Virtual Robots.txt

Переходим в админку Настройки > Virtual Robots.txt, видим знакомую конфигурацию, но нам нужно ее заменить, на нашу из статьи. Копируем и вставляем, не забываем сохранять.

Настройка Virtual Robots.txt

Настройка Virtual Robots.txt

Роботс автоматически создастся и станет доступен по тому же адресу. При желании проверить есть он в файлах WordPress – ничего не увидим, потому что документ виртуальный и редактировать можно только из плагина, но Yandex и Google он будет виден.

Добавить с помощью Yoast SEO

Знаменитый плагин Yoast SEO предоставляет возможность добавить и изменить robots.txt из панели WordPress. Причем созданный файл появляется на сервере (а не виртуально) и находится в корне сайта, то есть после удаления или деактивации роботс остается. Переходим в Инструменты > Редактор.

Yoast SEO редактор файлов

Yoast SEO редактор файлов

Если robots есть, то отобразится на странице, если нет есть кнопка “создать”, нажимаем на нее.

Кнопка создания robots

Кнопка создания robots

Выйдет текстовая область, записываем, имеющийся текст из универсальной конфигурации и сохраняем. Можно проверить по FTP соединению документ появится.

Изменить модулем в All in One SEO

Старый плагин All in One SEO умеет изменять robots txt, чтобы активировать возможность переходим в раздел модули и находим одноименный пункт, нажимаем Activate.

Модули в All In one Seo

Модули в All In one Seo

В меню All in One SEO появится новый раздел, заходим, видим функционал конструктора.

Работа в модуле AIOS

Работа в модуле AIOS

- Записываем имя агента, в нашем случае * или оставляем пустым

- Разрешаем или запрещаем индексацию

- Директория или страница куда не нужно идти

- Результат

Модуль не удобный, создать по такому принципу валидный и корректный robots.txt трудно. Лучше используйте другие инструменты.

Правильная настройка для плагина WooCommerce

Чтобы сделать правильную настройку для плагина интернет магазина на WordPress WooCommerce, добавьте эти строки к остальным:

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Disallow: /my-account/

Делаем аналогичные действия и загружаем на сервер через FTP или плагином.

Итог

Подведем итог что нужно сделать чтобы на сайте WordPress был корректный файл для поисковиков:

- Создаем вручную или с помощью плагина файл

- Записываем в него инструкции из статьи

- Загружаем на сервер

- Проверяем в валидаторе Yandex

- Не пользуйтесь генераторами robots txt в интернете, пошевелите немного руками

Совершенствуйте свои блоги на WordPress, продвигайтесь и правильно настраивайте все параметры, а мы в этом поможем, успехов!

Пожалуйста, оцените материал: Мне нравится14Не нравится

Правильный Robots.txt для WordPress (базовый и расширенный) [2020]

Автор Александр Смирнов На чтение 7 мин. Просмотров 10.9k. Обновлено

Правильный Robots.txt для WordPress в 2020-м году. Несколько версий под разные нужды: простая базовая и расширенная — с проработкой под каждую поисковую систему.

Одной из важнейших вещей при создании и оптимизации сайта для поисковых систем считают Robots.txt. Небольшой файлик, где прописаны правила индексирования для поисковых роботов.

Если файл будет настроен неправильно, то сайт может неправильно индексироваться и терять большие доли трафика. Грамотная настройка наоборот позволяет улучшить SEO, и вывести ресурс в топы.

Сегодня мы поговорим о настройке Robots.txt для WordPress. Я покажу вам правильный вариант, который сам использую для своих проектов.

Что такое Robots.txt

Как я уже и сказал, robots.txt — текстовой файлик, где прописаны правила для поисковых систем. Стандартный robots.txt для WordPress выглядит следующим образом:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Именно в таком виде он создается плагином Yoast SEO. Некоторые считают, что этого хватит для правильной индексации. Я же считаю, что нужна более детальная проработка. А если речь идет о нестандартных проектах, то проработка нужна и подавно. Давайте разберемся в основных директивах:

| Директива | Значение | Пояснение |

| User-agent: | Yandex, Googlebot и т.д. | В этой директиве можно указать к какому конкретно роботу мы обращаемся. Обычно используются те значения, которые я указал. |

| Disallow: | Относительная ссылка | Директива запрета. Ссылки, указанные в этой директиве будут игнорироваться поисковыми системами. |

| Allow: | Относительная ссылка | Разрешающая директива. Ссылки, которые указаны с ней будут проиндексированы. |

| Sitemap: | Абсолютная ссылка | Здесь указывается ссылка на XML-карту сайта. Если в файле не указать эту директиву, то придется добавлять карту вручную (через Яндекс.Вебмастер или Search Console). |

| Crawl-delay: | Время в секундах (пример: 2.0 — 2 секунды) | Позволяет указать таймаут между посещениями поисковых роботов. Нужна в случае, если эти самые роботы создают дополнительную нагрузку на хостинг. |

| Clean-param: | Динамический параметр | Если на сайте есть параметры вида site.ru/statia?uid=32, где ?uid=32 — параметр, то с помощью этой директивы их можно скрыть. |

В принципе, ничего сложного. Дам дополнительные пояснения по директивам Clean-param (откройте вкладку).

Подробнее о Clean-param

Параметры, как правило, используются на динамических сайтах. Они могут передавать поисковым системам лишнюю информацию — создавать дубли. Чтобы избежать этого, мы должны указать в Robots.txt директиву Clean-param с указанием параметра и ссылки, к которой это параметр применяется.

В нашем примере site.ru/statia?uid=32 — site.ru/statia — ссылка, а все, что после знака вопроса — параметр. Здесь это uid=32. Он динамический, и это значит, что параметр uid может принимать другие значения.

Например, uid=33, uid=34…uid=123434. В теории их может быть сколько угодно, поэтому мы должны закрыть от индексации все параметры uid. Для этого директива должна принять такой вид:

Clean-param: uid /statia # все параметры uid для statia будут закрыты

Более подробно о том, что такое Robots.txt можно узнать из Яндекс.Помощи. Или из этого видеоролика:

Базовый Robots.txt для WordPress

Совсем недавно я приобрел плагин Clearfy Pro для своих проектов. Там очень много разных функций, и одна из них — создание идеального Robots.txt. На самом деле насколько он идеален — я не знаю, вебмастера расходятся во мнениях.

Кто-то предпочитает делать более краткие версии роботса, указывая правила для всех поисковых систем сразу. Другие прописывают отдельные правила для каждого поисковика (в основном для Яндекса и Гугла).

Что из этого правильно — точно сказать не могу. Однако я предлагаю вам ознакомиться с базовой версией Robots.txt для WordPress от Clearfy Pro. Я немного подредактировал ее — указал директиву Sitemap. Удалил директиву Host.

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Allow: /*.css Allow: /*.js Sitemap: https://site.ru/sitemap.xml

Не могу сказать, что это лучший вариант для блогов на ВП. Но во всяком случае, он лучше, чем то, что нам предлагает Yoast SEO по умолчанию.

Расширенный Robots.txt для WordPress

Теперь посмотрим на расширенную версию Robots.txt для WordPress. Наверняка вы знаете, что все сайты на WP имеют одинаковую структуру. Одинаковые названия папок, файлов и т.д. позволяют специалистам выявить наиболее приемлемый вариант роботса.

В этой статье я хочу представить вам свой вариант Robots.txt. Его я использую как для своих сайтов, так и для клиентских. Вы могли видеть такой вариант и на других сайтах, т.к. он обладает некоторой популярностью.

Итак, правильный Robots.txt для WordPress выглядит следующим образом:

User-agent: * # Для всех поисковых систем, кроме Яндекса и Гугла Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем метки Disallow: /readme.html # Закрываем бесполезный мануал по установке WordPress (лежит в корне) Disallow: *?replytocom Allow: */uploads User-agent: GoogleBot # Для Гугла Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Disallow: /tag/ # Закрываем метки Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php User-agent: Yandex # Для Яндекса Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: /xmlrpc.php Disallow: /tag/ # Закрываем метки Disallow: /readme.html Disallow: *?replytocom Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign Clean-Param: openstat Sitemap: https://site.com/sitemap_index.xml # Карта сайта, меняем site.com на нужный адрес.

Важно:

Ранее в Robots.txt использовалась директива Host. Она указывала главное зеркало сайта. Теперь это делается при помощи редиректа. Подробнее об этом можно почитать в блоге Яндекса.

Комментарии (текст после #) можно удалить. Указываю Sitemap с https протоколом, т.к. большинство сайтов сейчас используют защищенное соединение. Если у вас нет SSL, то измените протокол на http.

Обратите внимание на то, что я закрываю метки (теги). Делаю это потому, что они создают большое количество дублей. Это плохо сказывается на SEO, но если вы хотите открыть метки, тогда уберите строчку disallow: /tag/ из файла.

Заключение

В общем-то, вот так выглядит правильный Robots.txt для WordPress. Смело копируйте данные в файл и пользуйтесь. Отмечу, что этот вариант подходит только для стандартных информационных сайтов.

В других ситуациях может потребоваться индивидуальная проработка. На этом все. Спасибо за внимание. Буду благодарен, если вы включите уведомления через колокольчик и подпишитесь на почтовую рассылку. Тут будет круто :).

Видео на десерт: Фермер Хотел Найти Воду, но То Что Случилось Удивило Весь Мир

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

( 17 оценок, среднее 5 из 5 )

Как создать файл robots.txt для WordPress. 4 способа

Всем, привет! Сегодня небольшой пост — как автоматически создать файл robots.txt для WordPress? Друзья, вы можете создать правильный robots.txt для WordPress в пару кликов, прочитав данное руководство. Создание правильного файла robots.txt для WordPress очень важно. Благодаря ему поисковые системы будут знать, какие страницы индексировать и показывать в поиске. То есть, результаты поиска будут именно такими, как вам нужно, без дублирования страниц WordPress.

robots.txt для сайта WordPress

robots.txt для сайта WordPress

Читайте, дамы и господа — WordPress robots.txt: лучшие примеры для SEO.

Файл robots.txt для WordPress

WordPress robots.txt где лежит/находится? По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Таким образом, даже если вы ни чего не делали, на вашем сайте ВордПресс уже должен быть файл robots.txt. Вы можете проверить, так ли это, добавив /robots.txt в конец вашего доменного имени. Например, так https://ваш сайт/robots.txt

Виртуальный файл robots.txt в WordPress

Виртуальный файл robots.txt в WordPress

Поскольку этот файл является виртуальным, вы не можете его редактировать. Однако, если вы хотите отредактировать свой файл robots.txt WordPress как надо, вам необходимо создать физический файл на вашем хостинге. Создайте свой правильный robots.txt для WordPress, который вы сможете легко редактировать по мере необходимости.

Как создать файл robots.txt для WordPress

Robots.txt — это текстовый файл, который содержит параметры индексирования сайта для роботов поисковых систем.

Файл robots.txt сообщает поисковым роботам, какие страницы или файлы на вашем сайте можно или нельзя обрабатывать.

Яндекс и Google

Для начала напомню вам, создать (и редактировать) файл robots.txt для WordPress можно вручную и с помощью плагина Yoast SEO

Создать файл robots.txt

Создать файл robots.txt

Друзья, имейте ввиду, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt ВордПресс:

Редактирование robots.txt в плагине Yoast SEO

Редактирование robots.txt в плагине Yoast SEO

Что должно быть в правильно составленного robots.txt? Идеального файла не существует. Например, сайт Yoast SEO использует такой robots.txt для WordPress:

User-agent: *И всё. Для большинства сайтов WordPress лучший пример. Вот даже скриншот сделал у Yoast SEO:

Правильный robots.txt на сайте yoast.com

Правильный robots.txt на сайте yoast.com

Что это значит? Директива говорит что, все поисковые роботы могут свободно сканировать этот сайт без ограничений. Этого хватит для правильной индексации сайта WP. А наша SEO специалисты рекомендуют почти тоже самое. Пример, правильно составленного robots.txt для WordPress сайта:

User-agent: *

Disallow:

Sitemap: https://mysite.ru/sitemap.xmlДанная запись в файле роботс делает доступным для индексирования полностью сайт для роботов всех известных поисковиков. Здесь, также прописан путь к карте сайта XML.

Создать и редактировать файл также можно при помощи All in One SEO Pack прямо из интерфейса SEO плагина. Модуль robots.txt в SEO-пакете Все в одном позволяет вам настроить файл robots.txt для вашего сайта, который переопределит файл robots.txt по умолчанию, который создает WordPress:

Применение плагина All in One SEO Pack

Применение плагина All in One SEO Pack

Вы сможете управлять своим файлом Robots.txt, в разделе All in One SEO Pack — Robots.txt. Сам официальный сайт плагина использует вот такой роботс:

Пример файла Robots

Пример файла Robots

Правила по умолчанию, которые отображаются в поле Создать файл Robots.txt (показано на снимке экрана выше), требуют, чтобы роботы не сканировали ваши основные файлы WordPress. Для поисковых систем нет необходимости обращаться к этим файлам напрямую, потому что они не содержат какого-либо релевантного контента сайта.

А если вы не используете данные SEO модули, то предлагаю вам воспользоваться специальным плагином — Robots.txt Editor.

Плагин Robots.txt Editor

Плагин Robots.txt для WordPress — создание и редактирование файла robots.txt для сайта ВордПресс. Очень простой, лёгкий и эффективный плагин.

WordPress плагин Robots.txt Editor

WordPress плагин Robots.txt Editor

Плагин Robots.txt Editor (редактор) позволяет создать и редактировать файл robots.txt на вашем сайте WordPress.

Плагин Robots.txt возможности

- Работает в сети сайтов Multisite на поддоменах;

- Пример правильного файла robots.txt для WordPress;

- Не требует дополнительных настроек;

- Абсолютно бесплатный.

Как использовать? Установите плагин robots.txt стандартным способом. То есть, из админки. Плагины — Добавить новый. Введите в окно поиска его название — Robots.txt Editor:

Добавить плагин Robots.txt Editor

Добавить плагин Robots.txt Editor

Установили и сразу активировали. Всё, готово. Теперь смотрим, что получилось. Заходим, Настройки — Чтение и видим результат. Автоматически созданный правильный файл robots.txt для WordPress со ссылкой на ваш файл Sitemap. Пример, правильный robots.txt для сайта ВордПресс:

Созданный файл robots.txt WordPress

Созданный файл robots.txt WordPress

Естественно, вы можете его легко отредактировать под свои нужды. А также просмотреть, нажав соответствующею ссылку — Просмотр robots.txt.

Как создать robots.txt вручную

Если вы не захотите использовать плагины, которые предлагают функцию robots.txt, вы все равно можете создать и управлять своим файлом robots.txt на своём хостинге. Как создать файл robots.txt самостоятельно?

В текстовом редакторе создайте файл с именем robots в формате txt и заполните его:

Создать файл с именем robots.txt

Создать файл с именем robots.txt

Файл должен иметь имя robots.txt и никакое другое больше. Сохраните данный файл локально на компьютере. А затем, загрузите созданный файл в корневую директорию вашего сайта.

Корневая папка (корневая директория/корневой каталог/корень документа) — это основная папка, в которой хранятся все файлы сайта. Обычно, это папка public_html (там где находятся файлы — .htaccess, wp-config.php и другие). Именно в эту папку загружается файл robots.txt:

Загрузите файл в корневую папку вашего сайта

Загрузите файл в корневую папку вашего сайта

Чтобы проверить, получилось ли у вас положить файл в нужное место, перейдите по адресу: https://ваш_сайт.ru/robots.txt

Теперь, когда ваш файл robots.txt создан и загружен на сайт, вы можете проверить его на ошибки.

Проверка вашего файла robots.txt

Вы можете проверить файл robots.txt WordPress в Google Search Console и Яндекс.Вебмастер, чтобы убедиться, что он правильно составлен.

Например, проверка файла robots.txt WordPress в Яндекса.Вебмастер. В блоке Результаты анализа robots.txt перечислены директивы, которые будет учитывать робот при индексировании сайта.

Анализ robots.txt в Яндекс.Вебмастер

Анализ robots.txt в Яндекс.Вебмастер

Если будет найдена ошибка, информация об этом будет показана вам.

В заключение

Для некоторых сайтов WordPress нет необходимости срочно изменять стандартный виртуальный файл robots.txt (по умолчанию). Но, если вам нужен физический файл robots.txt, то используйте плагины Robots.txt Editor, All in One SEO Pack или Yoast SEO. С ними можно легко редактировать файл прямо из панели инструментов WordPress, чтобы добавить свои собственные правила.

До новых встреч, друзья и я надеюсь, что вам понравилось это маленькое руководство. И не стесняйтесь, обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы по использованию файла robots.txt на сайте WordPress.

Правильный Robots.txt для WordPress (2020) — как сделать?

В интернете можно найти много публикаций на тему, как составить лучший (или даже самый лучший) файл robots.txt для WordPress. При этом в ряде таких популярных статей многие правила не объясняются и, как мне кажется, вряд ли понимаются самими авторами. Единственный обзор, который я нашел и который действительно заслуживает внимания, — это статья в блоге wp-kama. Однако и там я нашел не совсем корректные рекомендации. Понятно, что на каждом сайте будут свои нюансы при составлении файла robots.txt. Но существует ряд общих моментов для совершенно разных сайтов, которые можно взять за основу. Robots.txt, опубликованный в этой статье, можно будет просто копировать и вставлять на новый сайт и далее дорабатывать в соответствии со своими нюансами.

Более подробно о составлении robots.txt и значении всех его директив я писал здесь. Ниже я не буду подробно останавливаться на значении каждого правила. Ограничусь тем, что кратко прокомментирую что для чего необходимо.

Правильный Robots.txt для WordPress

Действительно самый лучший robots.txt, который я видел на данный момент, это роботс, предложенный в блоге wp-kama. Ряд директив и комментариев я возьму из его образца + внесу свои корректировки. Корректировки коснутся нескольких правил, почему так напишу ниже. Кроме того, напишем индивидуальные правила для всех роботов, для Яндекса и для Google.

Ниже привожу короткий и расширенный вариант. Короткий не включает отдельные блоки для Google и Яндекса. Расширенный уже менее актуален, т.к. теперь нет принципиальных особенностей между двумя крупными поисковиками: обеим системам нужно индексировать файлы скриптов и изображений, обе не поддерживают директиву Host. Тем не менее, если в этом мире снова что-то изменится, либо вам потребуется все-таки как-то по-отдельному управлять индексацией файлов на сайте Яндексом и Гугл, сохраню в этой статье и второй вариант.

Еще раз обращаю внимание, что это базовый файл robots.txt. В каждом конкретном случае нужно смотреть реальный сайт и по-необходимости вносить корректировки. Поручайте это дело опытным специалистам!

Короткий вариант (оптимальный)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruРасширенный вариант (отдельные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Укажите главное зеркало сайта, как в примере ниже (с WWW / без WWW, если HTTPS

# то пишем протокол, если нужно указать порт, указываем). Команда стала необязательной. Ранее Host понимал

# Яндекс и Mail.RU. Теперь все основные поисковые системы команду Host не учитывают.

Host: www.site.ruВ примере я не добавляю правило Crawl-Delay, т.к. в большинстве случаев эта директива не нужна. Однако если у вас крупный нагруженный ресурс, то использование этой директивы поможет снизить нагрузку на сайт со стороны роботов Яндекса, Mail.Ru, Bing, Yahoo и других (Google не учитывает). Подробнее про это читайте в статье Robots.txt.

Ошибочные рекомендации других блогеров для Robots.txt на WordPress

- Использовать правила только для User-agent: *

Для многих поисковых систем не требуется индексация JS и CSS для улучшения ранжирования, кроме того, для менее значимых роботов вы можете настроить большее значение Crawl-Delay и снизить за их счет нагрузку на ваш сайт. - Прописывание Sitemap после каждого User-agent

Это делать не нужно. Один sitemap должен быть указан один раз в любом месте файла robots.txt - Закрыть папки wp-content, wp-includes, cache, plugins, themes

Это устаревшие требования. Однако подобные советы я находил даже в статье с пафосным названием «Самые правильный robots для WordPress 2018»! Для Яндекса и Google лучше будет их вообще не закрывать. Или закрывать «по умному», как это описано выше. - Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика - Закрывать от индексации страницы пагинации /page/

Это делать не нужно. Для таких страниц настраивается тег rel=»canonical», таким образом, такие страницы тоже посещаются роботом и на них учитываются расположенные товары/статьи, а также учитывается внутренняя ссылочная масса. - Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей. - Ляпы

Некоторые правила я могу отнести только к категории «блогер не подумал». Например:Disallow: /20— по такому правилу не только закроете все архивы, но и заодно все статьи о 20 способах или 200 советах, как сделать мир лучше 🙂

Спорные рекомендации других блогеров для Robots.txt на WordPress

- Комментарии

Некоторые ребята советуют закрывать от индексирования комментарииDisallow: /commentsиDisallow: */comment-*. - Открыть папку uploads только для Googlebot-Image и YandexImages

User-agent: Googlebot-ImageСовет достаточно сомнительный, т.к. для ранжирования страницы необходима информация о том, какие изображения и файлы размещены на ней.

Allow: /wp-content/uploads/

User-agent: YandexImages

Allow: /wp-content/uploads/

Спасибо за ваше внимание! Если у вас возникнут вопросы или предложения, пишите в комментариях!

Оцените статью

Загрузка…

Загрузка…

Друзья, буду благодарен за ваши вопросы, дополнения и рекомендации по теме статьи. Пишите ниже в комментариях.

Буду благодарен, если поставите оценку статье.

Правильный robots.txt для WordPress — 2020

Robots.txt – текстовой файл, который сообщает поисковым роботам, какие файлы и папки следует сканировать (индексировать), а какие сканировать не нужно.

Поисковые системы, такие как Яндекс и Google сначала проверяют файл robots.txt, после этого начинают обход с помощью веб-роботов, которые занимаются архивированием и категоризацией веб сайтов.

Файл robots.txt содержит набор инструкций, которые просят бота игнорировать определенные файлы или каталоги. Это может быть сделано в целях конфиденциальности или потому что владелец сайта считает, что содержимое этих файлов и каталогов не должны появляться в выдаче поисковых систем.

Если веб-сайт имеет более одного субдомена, каждый субдомен должен иметь свой собственный файл robots.txt. Важно отметить, что не все боты будут использовать файл robots.txt. Некоторые злонамеренные боты даже читают файл robots.txt, чтобы найти, какие файлы и каталоги Вы хотели скрыть. Кроме того, даже если файл robots.txt указывает игнорировать определенные страницы на сайте, эти страницы могут по-прежнему появляться в результатах поиска, если на них ссылаются другие просканированные страницы. Стандартный роботс тхт для вордпресс открывает весь сайт для интдекса, поэтому нам нужно закрыть не нужные разделы WordPress от индексации.

Оптимальный robots.txt

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # системная папка на хостинге, закрывается всегда

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # запрос поиска

Disallow: *&s= # запрос поиска

Disallow: /search/ # запрос поиска

Disallow: /author/ # архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть

# архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Host прописывать больше не нужно.Расширенный вариант (разделенные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Host прописывать больше не нужно.Оптимальный Robots.txt для WooCommerce

Владельцы интернет-магазинов на WordPress – WooCommerce также должны позаботиться о правильном robots.txt. Мы закроем от индексации корзину, страницу оформления заказа и ссылки на добавление товара в корзину.

User-agent: *

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Disallow: /cart/

Disallow: /checkout/

Disallow: /*add-to-cart=*

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Sitemap: https://site.ru/sitemap_index.xmlГде находится файл robots.txt в WordPress

Обычно robots.txt располагается в корне сайта. Если его нет, то потребуется создать текстовой файл и загрузить его на сайт по FTP или панель управления на хостинге. Если Вы не смогли найти robots.txt в корне сайта, но при переходе по ссылке вашсайт.ру/robots.txt он открывается, значит какой то из SEO плагинов сам генерирует его.

К примеру плагин Yoast SEO создает виртуальный файл, которого нет в корне сайта.

Как редактировать robots.txt с помощью Yoast SEO

- Зайдите в админ панель сайта

Админа панель находится по следующему адресу вашсайт.ру/wp-admin/

- Слева в консоли наведите на кнопку SEO и в выпадающем окне выберите “Инструменты”. Перейдите в раздел, как указано на картинке.

- Зайдите в редактор файлов

Этот инструмент позволит быстро отредактировать такие важные для вашего SEO файлы, как robots.txt и .htaccess (при его наличии).

- Если файла robots.txt нет, нажмите на кнопку создать, либо вставьте нужное содержимое.

Содержимое файла для WordPress и WooCommerce можно взять из примеров выше.

- Сохраните изменения в robots.txt

После сохранения файла вы можете проверить правильность через сервисы проверки.

Чтобы установить плагин Yoast SEO воспользуйтесь данной статьей – ссылка.

Часто задаваемые вопросы

Закрывать ли feed в robots.txt?

По умолчанию мы рекомендуем закрывать feed от индексации в robots.txt. Открытие feed может потребоваться, если вы например настраиваете Турбо-страницы от Яндекса или выгружаете свою ленту в другой сервис.

Как разрешить индексировать feed Турбо-страниц

Добавьте директиву: Allow: /feed/turbo/, тогда Яндекс сможет проверять ваши турбо-страницы и обновлять их.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

правильный пример на WordPress для Яндекса и Google

Всем привет! Сегодня я бы хотел Вам рассказать про файл robots.txt. Да, про него очень много чего написано в интернете, но, если честно, я сам очень долгое время не мог понять, как же создать правильный robots.txt. В итоге я сделал один и он стоит на всех моих блогах. Проблем с индексацией сайта я не замечаю, robots.txt работает просто великолепно.

Robots.txt для WordPress

А зачем, собственно говоря, нужен robots.txt? Ответ все тот же – продвижение сайта в поисковых системах. То есть составление robots.txt – это одно из частей поисковой оптимизации сайта (кстати, очень скоро будет урок, который будет посвящен всей внутренней оптимизации сайта на WordPress. Поэтому не забудьте подписаться на RSS, чтобы не пропустить интересные материалы.).

Одна из функций данного файла – запрет индексации ненужных страниц сайта. Также в нем задается адрес карты сайта sitemap.xml и прописывается главное зеркало сайта (сайт с www или без www).

Примечание: для поисковых систем один и тот же сайт с www и без www совсем абсолютно разные сайты. Но, поняв, что содержимое этих сайтов одинаковое, поисковики “склеивают” их. Поэтому важно прописать главное зеркало сайта в robots.txt. Чтобы узнать, какое главное (с www или без www), просто наберите адрес своего сайта в браузере, к примеру, с www, если Вас автоматически перебросит на тот же сайт без www, значит главное зеркало Вашего сайта без www. Надеюсь правильно объяснил.

Было:

Стало (после перехода на сайт, www автоматически удалились, и сайт стал без www):

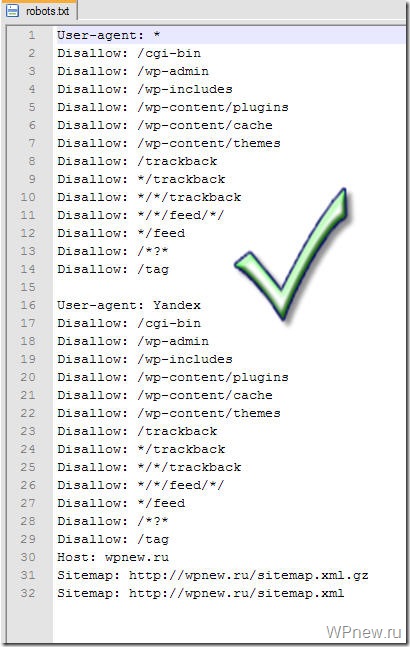

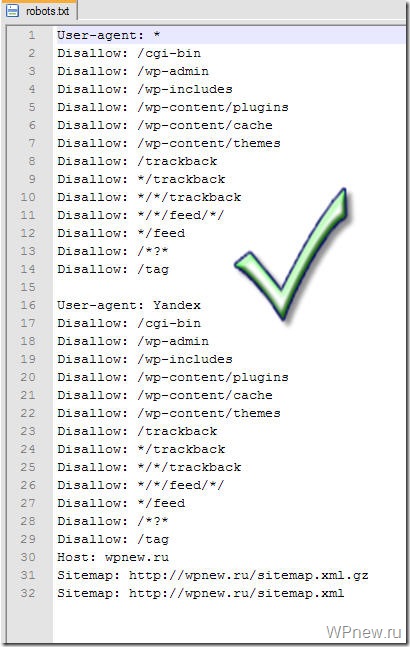

Так вот, этот заветный, по-моему, правильный robots.txt для WordPress Вы можете увидеть ниже.

Правильный Robots.txt для WordPress

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: wpnew.ru

Sitemap: https://wpnew.ru/sitemap.xml.gz

Sitemap: https://wpnew.ru/sitemap.xml

Все что дано выше, Вам нужно скопировать в текстовой документ с расширением .txt, то есть, чтобы название файла было robots.txt. Данный текстовой документ Вы можете создать, к примеру, с помощью программы Notepad++. Только, не забудьте, пожалуйста, изменить в последних трех строчках адрес wpnew.ru на адрес своего сайта. Файл robots.txt должен располагаться в корне блога, то есть в той же папке, где находятся папки wp-content, wp-admin и др. .

Те, кому же лень создавать данный текстовой файл, можете просто скачать robots.txt и также там подкорректировать 3 строчки.

Хочу отметить, что в техническими частями, о которых речь пойдет ниже, себя сильно загружать не нужно. Привожу их для “знаний”, так сказать общего кругозора, чтобы знали, что и зачем нужно.

Итак, строка:

User-agent

задает правила для какого-то поисковика: к примеру “*” (звездочкой) отмечено, что правила для всех поисковиков, а то, что ниже

User-agent: Yandex

означает, что данные правила только для Яндекса.

Disallow

Здесь же Вы “засовываете” разделы, которые НЕ нужно индексировать поисковикам. К примеру, на странице https://wpnew.ru/tag/seo у меня идет дубль статей (повторение) с обычными статьями, а дублирование страниц отрицательно сказывается на поисковом продвижении, поэтому, крайне желательно, данные секторы нужно закрыть от индексации, что мы и делаем с помощью этого правила:

Disallow: /tag

Так вот, в том robots.txt, который дан выше, от индексации закрыты почти все ненужные разделы сайта на WordPress, то есть просто оставьте все как есть.

Host

Здесь мы задаем главное зеркало сайта, о котором я рассказывал чуть выше.

Sitemap

В последних двух строчках мы задаем адрес до двух карт сайта, созданные с помощью плагина Google XML Sitemaps.

Возможные проблемы

Если у Вас на блоге не стоит ЧПУ (именно так у меня происходит с тем сайтом, которого я занимаюсь продвижением), то с тем robots.txt, который дан выше, могут быть проблемы. Напомню, что без ЧПУ ссылки на сайте на посты выглядят примерно следующим образом:

А вот из-за этой строчки в robots.txt, у меня перестали индексироваться посты сайта:

Disallow: /*?*

Как видите, эта самая строка в robots.txt запрещает индексирование статей, что естественно нам нисколько не нужно. Чтобы исправить это, просто нужно удалить эти 2 строчки (в правилах для всех поисковиков и для Яндекса) и окончательный правильный robots.txt для WordPress сайта без ЧПУ будет выглядеть следующим образом:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

Host: wpnew.ru

Sitemap: https://wpnew.ru/sitemap.xml.gz

Sitemap: https://wpnew.ru/sitemap.xml

Анализ robots.txt

Чтобы проверить, правильно ли мы составили файл robots.txt я рекомендую Вам воспользоваться сервисом Яндекс Вебмастер (как регистрироваться в данном сервисе я рассказывал тут).

Заходим в раздел Настройки индексирования –> Анализ robots.txt:

Уже там нажимаете на кнопку “Загрузить robots.txt с сайта”, а затем нажимаете на кнопку “Проверить”:

Если Вы увидите примерно следующее сообщение, значит у Вас правильный robots.txt для Яндекса:

Также Вы можете в “Список URL” добавить адрес любой статьи сайта, чтобы проверить не запрещает ли robots.txt индексирование данной страницы:

Как видите, никакого запрета на индексирование страницы со стороны robots.txt мы не видим, значит все в порядке :).

Надеюсь больше вопросов, типа: как составить robots.txt или как сделать правильным данный файл у Вас не возникнет. В этом уроке я постарался показать Вам правильный пример robots.txt:

Вы можете посмотреть другие варианты, как еще можно составлять robots.txt.

До скорой встречи!

P.s. Совсем недавно я добавил блог в Яндекс Каталог, что же интересного произошло? 🙂

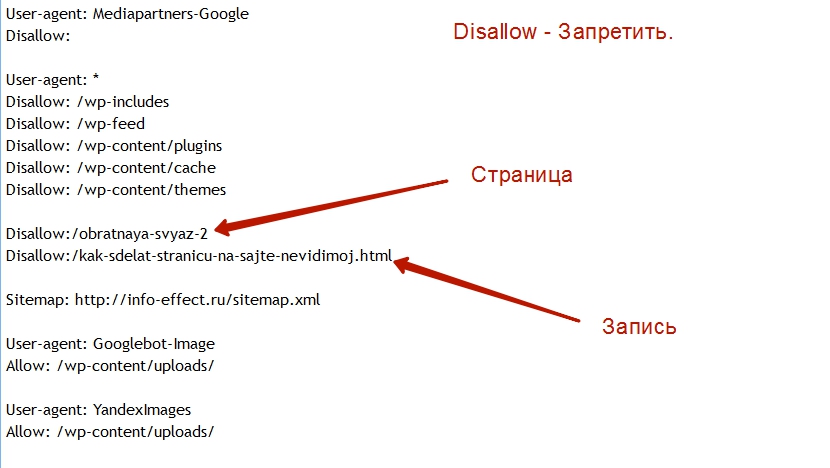

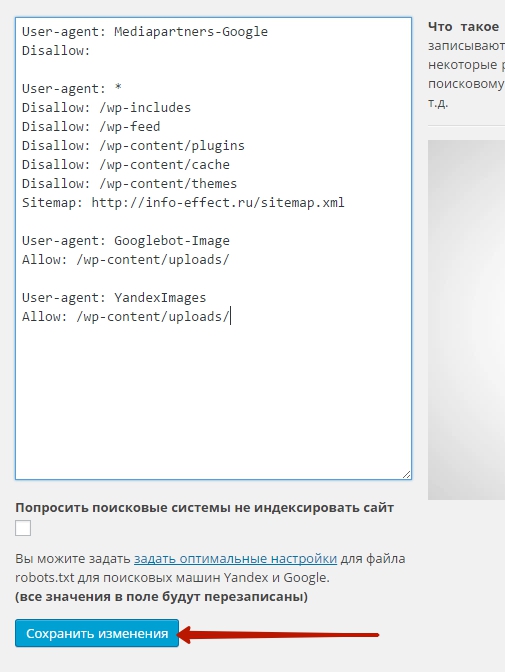

Плагин wordpress robots.txt установка и настройка – info-effect.ru

На чтение 4 мин. Опубликовано

Здравствуйте !

Сегодня я покажу вам и расскажу как пользоваться файлом robots.txt. Что это такое ? файл robots.txt позволит вам скрывать от индексации некоторые разделы или отдельные страницы вашего сайта, чтобы они не попадали в поиск Google и Yandex. Для чего это нужно ? поисковые системы индексируют всё содержимое вашего сайта без разбора, поэтому если вы хотите скрыть какую-либо конфиденциальную информацию,

например личные данные ваших пользователей, переписка, счета и т.д., то вам нужно будет самостоятельно добавить адреса страниц с данными в файл robots.txt. Что ещё можно сделать с помощью файла robots.txt ? если у вашего сайта есть зеркала, то в их файлах robots.txt можно указать на главный сайт, чтобы индексировался только он.

Видео о файле robots.txt

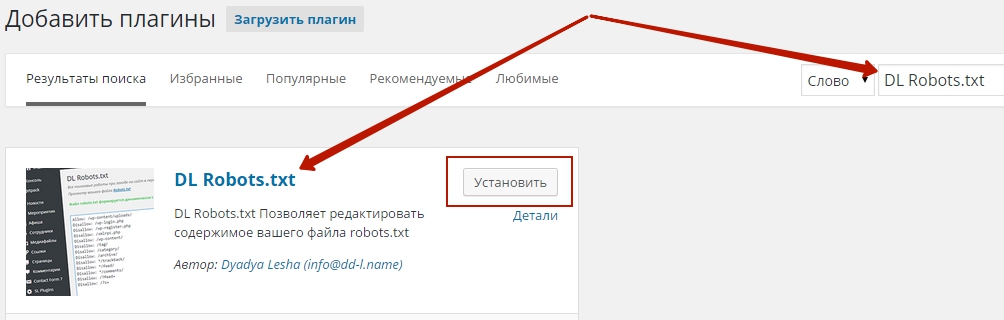

Настраивать файл robots.txt мы будем с помощью плагина – DL Robots.txt. Установить данный плагин вы сможете прямо из своей админ-панели wordpress. Перейдите по вкладке: Плагины – Добавить новый, введите название плагина в форму поиска, нажмите Enter, установите и активируйте открывшийся плагин.

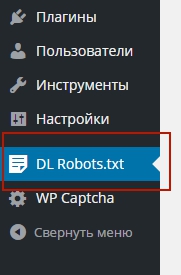

Чтобы попасть на страницу настроек плагина, перейдите по вкладке: DL Robots.txt. Данная вкладка появится у вас в меню админ-панели wordpress, после того как вы установите и активируете плагин.

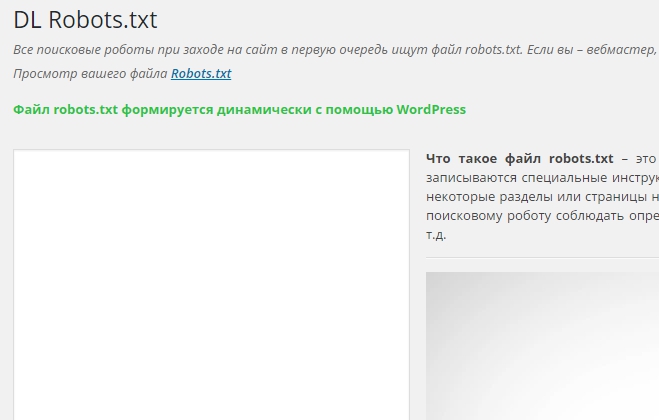

На странице настройки файла robots.txt, вы можете прочитать и посмотреть видео о том, что такое файл robots.txt. Так же здесь можно проверить файл, нажав на вкладку – Robots.txt, если файл откроется в браузере значит всё нормально.

Если на вашем сайте нет файла robots.txt, значит сейчас мы добавим его в специальное окно, которое находится на странице настроек плагина. Итак, конечно же создавать файл robots.txt необходимо исходя из предпочтений каждого отдельного сайта, но я вам предложу готовый вид файла, который подойдёт любому сайту на wordpress. В случае чего вы сможете с лёгкостью добавить в файл свои дополнения.

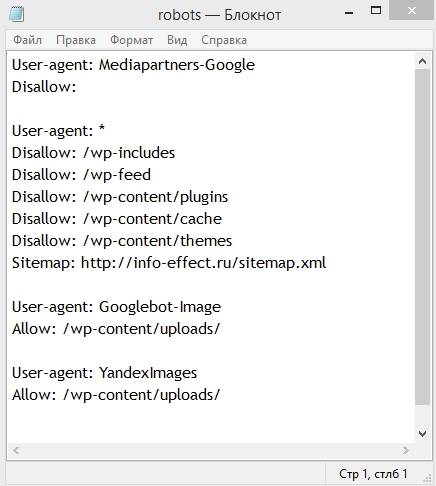

Вот как выглядит файл robots.txt для моего сайта.

Сейчас я объясню вам, что всё это значит.

В общем, если не вдаваться в подробности, то я запретил поисковикам индексировать: темы и плагины wordpress, кэш сайта, то есть дубликаты страниц, feed – это rss лента с записями. Теперь объясню зачем это делать, этим самым мы облегчаем работу поискового робота, чтобы он не индексировал лишний груз сайта, темы, плагины, кэш, фид, всё это можно не индексировать, в поиске вся эта информация просто не нужна.

Так же в файле указано – разрешить поисковикам индексировать все загруженные медиафайлы на вашем сайте. Такой файл robots.txt подойдёт любому сайту на wordpress.

Смотрите, к примеру вы хотите не индексировать ещё какую-либо отдельную страницу или запись на вашем сайте, тогда файл будет выглядеть следующим образом:

Поняли да, то есть добавляете только название страницы из её ссылки и впереди ставите флэш /, а для записи, название записи.html и впереди флэш /.

Итак, скачать готовый файл robots.txt можно – Здесь ! Только Внимание ! ! ! укажите свой адрес сайта вместо моего.

После того как вы скачаете файл, у вас будет два варианта:

- Загрузить файл в свою корневую директорию на хостинге. (в этом случае плагин можно не устанавливать)

- Скопировать содержание файла и вставить в специальное окно на странице настройки плагина DL Robots.txt

На этом у меня всё, если у вас остались вопросы по данной статье, то обязательно напишите мне в Обратную связь, либо оставьте комментарий к данной записи. Я всем отвечу ! Кстати, а вы проверяли файл robots.txt в Яндекс вебмастер ?

Удачи вам и до новых встреч ! ![]()

Оптимизация

WordPress Robots.txt (+ XML Sitemap) — посещаемость веб-сайта, поисковая оптимизация и повышение рейтинга — плагин WordPress

Better Robots.txt создает виртуальный файл robots.txt WordPress, помогает вам повысить SEO вашего сайта (возможности индексации, рейтинг Google и т. Д.) И производительность загрузки — Совместимость с Yoast SEO, Google Merchant, WooCommerce и сетевыми сайтами на основе каталогов ( МУЛЬТИСИТ)

С помощью Better Robots.txt вы можете определить, каким поисковым системам разрешено сканировать ваш сайт (или нет), указать четкие инструкции о том, что им разрешено (или нет), и определить задержку сканирования (для защиты вашего хостинг-сервера от агрессивные скребки).Better Robots.txt также дает вам полный контроль над содержимым файла robots.txt в WordPress с помощью окна пользовательских настроек.

Уменьшите экологический след своего сайта и выбросы парниковых газов (CO2), обусловленные его существованием в сети.

Краткий обзор:

ПОДДЕРЖИВАЕТСЯ НА 7 ЯЗЫКАХ

Плагины

Better Robots.txt переведены и доступны на следующих языках: китайский — 汉语 / 漢語, английский, французский — Français, русский –Руссɤɢɣ, португальский — Português, испанский — Español, немецкий — Deutsch

Знаете ли вы, что…

- Роботы.txt — это простой текстовый файл, размещаемый на вашем веб-сервере, который сообщает поисковым роботам (например, роботу Google), следует ли им обращаться к файлу.

- Файл robots.txt определяет, как пауки поисковых систем видят ваши веб-страницы и взаимодействуют с ними;

- Этот файл и боты, с которыми они взаимодействуют, являются фундаментальными частями работы поисковых систем;

- Первое, на что смотрит сканер поисковой системы при посещении страницы, — это файл robots.txt;

Роботы.txt — это источник сока SEO, который только и ждет, чтобы его разблокировали. Попробуйте Better Robots.txt!

О версии Pro (дополнительные возможности):

1. Повысьте свой контент в поисковых системах с помощью карты сайта!

Убедитесь, что ваши страницы, статьи и продукты, даже самые последние, принимаются во внимание поисковыми системами!

Плагин Better Robots.txt был создан для работы с плагином Yoast SEO (вероятно, лучшим плагином SEO для веб-сайтов WordPress).Он определит, используете ли вы в настоящее время Yoast SEO и активирована ли функция карты сайта. Если это так, он автоматически добавит инструкции в файл Robots.txt, предлагая ботам / сканерам прочитать вашу карту сайта и проверить, внесли ли вы последние изменения на свой сайт (чтобы поисковые системы могли сканировать новый доступный контент).

Если вы хотите добавить свою собственную карту сайта (или если вы используете другой плагин SEO), вам просто нужно скопировать и вставить URL-адрес вашей карты сайта и Better Robots.txt добавит его в ваш WordPress Robots.txt.

2. Защитите свои данные и контент

Не позволяйте плохим ботам сканировать ваш сайт и коммерциализировать ваши данные.

Плагин Better Robots.txt помогает заблокировать сканирование и очистку ваших данных наиболее популярными вредоносными ботами.

Когда дело доходит до сканирования вашего сайта, есть хорошие и плохие боты. Хорошие боты, такие как бот Google, сканируют ваш сайт, чтобы проиндексировать его для поисковых систем. Другие сканируют ваш сайт по более гнусным причинам, таким как удаление вашего контента (текст, цена и т. Д.)) для переиздания, загрузки целых архивов вашего сайта или извлечения изображений. Сообщалось, что некоторые боты даже закрывали целые веб-сайты в результате интенсивного использования широкополосного доступа.

Плагин Better Robots.txt защищает ваш сайт от «пауков» / парсеров, которые Distil Networks определили как плохие боты.

3. Скрыть и защитить обратные ссылки

Не позволяйте конкурентам определять ваши прибыльные обратные ссылки.

Обратные ссылки, также называемые «входящими ссылками» или «входящими ссылками», создаются, когда один веб-сайт ссылается на другой.Ссылка на внешний веб-сайт называется обратной ссылкой. Обратные ссылки особенно ценны для SEO, потому что они представляют собой «вотум доверия» от одного сайта к другому. По сути, обратные ссылки на ваш сайт являются сигналом для поисковых систем о том, что другие ручаются за ваш контент.

Если многие сайты ссылаются на одну и ту же веб-страницу или веб-сайт, поисковые системы могут сделать вывод, что контент заслуживает ссылки и, следовательно, также стоит показывать в поисковой выдаче. Таким образом, получение этих обратных ссылок оказывает положительное влияние на позицию сайта в рейтинге или видимость в поисковой сети.В индустрии SEM специалисты очень часто определяют, откуда берутся эти обратные ссылки (от конкурентов), чтобы отсортировать лучшие из них и создать высококачественные обратные ссылки для своих клиентов.

Учитывая, что создание очень прибыльных обратных ссылок для компании занимает много времени (время + энергия + бюджет), позволяя вашим конкурентам так легко идентифицировать и дублировать их, это чистая потеря эффективности.

Better Robots.txt поможет вам заблокировать всех поисковых роботов (aHref, Majestic, Semrush), чтобы ваши обратные ссылки не обнаруживались.

4. Избегайте спамовых обратных ссылок

Боты, заполняющие формы комментариев на вашем веб-сайте, говорят вам «отличная статья», «нравится информация», «надеются, что вы скоро сможете подробнее рассказать о теме» или даже предоставляют персональные комментарии, в том числе имя автора. Спам-боты со временем становятся все более и более умными, и, к сожалению, ссылки для спама в комментариях могут действительно повредить вашему профилю обратных ссылок. Улучшенный Robots.txt поможет вам избежать индексации этих комментариев поисковыми системами.

5.SEO инструменты

При улучшении нашего плагина мы добавили ссылки на 2 очень важных инструмента (если вас беспокоит ваш рейтинг в поисковых системах): Google Search Console и Bing Webmaster Tool. Если вы еще не используете их, теперь вы можете управлять индексированием своего сайта, оптимизируя robots.txt! Также был добавлен прямой доступ к инструменту массового пинга, который позволяет пинговать свои ссылки в более чем 70 поисковых системах.

Мы также создали 4 ярлыка, относящиеся к лучшим онлайн-инструментам SEO, непосредственно доступным на Better Robots.txt SEO PRO. Так что теперь, когда вы захотите, вы можете проверить производительность загрузки вашего сайта, проанализировать свой SEO-рейтинг, определить свой текущий рейтинг в поисковой выдаче с помощью ключевых слов и трафика и даже просканировать весь сайт на наличие мертвых ссылок (ошибки 404, 503, …) Прямо из плагина.

6. Будьте уникальны

Мы подумали, что можем добавить нотку оригинальности в Better Robots.txt, добавив функцию, позволяющую «настраивать» ваш файл robots.txt WordPress с помощью собственной уникальной «подписи».«Большинство крупных компаний в мире персонализировали свой robots.txt, добавив пословицы (https://www.yelp.com/robots.txt), слоганы (https://www.youtube.com/robots.txt) или даже рисунки (https://store.nike.com/robots.txt — внизу). И почему не ты тоже? Вот почему мы выделили специальную область на странице настроек, где вы можете писать или рисовать все, что хотите (действительно), не влияя на эффективность работы robots.txt.

7. Запретить роботам сканировать бесполезные ссылки WooCommerce

Мы добавили уникальную функцию, позволяющую блокировать определенные ссылки («добавить в корзину», «заказать», «заполнить», корзину, аккаунт, оформить заказ и т. Д.) От сканирования поисковыми системами.Большинство этих ссылок требуют значительного использования ЦП, памяти и полосы пропускания (на сервере хостинга), поскольку они не кэшируются и / или создают «бесконечные» циклы сканирования (пока они бесполезны). Оптимизация вашего файла robots.txt в WordPress для WooCommerce при наличии интернет-магазина позволяет увеличить вычислительную мощность для действительно важных страниц и повысить производительность загрузки.

8. Избегайте ловушек на гусеничном ходу:

«Ловушки поискового робота» — это структурная проблема внутри веб-сайта, которая заставляет сканеры находить практически бесконечное количество нерелевантных URL-адресов.Теоретически сканеры могут застрять в одной части веб-сайта и никогда не завершить сканирование этих нерелевантных URL-адресов. Улучшенный файл Robots.txt помогает предотвратить ловушки сканера, которые сокращают бюджет сканирования и вызывают дублирование контента.

9. Инструменты взлома роста

Сегодня самые быстрорастущие компании, такие как Amazon, Airbnb и Facebook, добились резкого роста, объединив свои команды вокруг высокоскоростного процесса тестирования / обучения. Речь идет о взломе роста. Взлом роста — это процесс быстрого экспериментирования и реализации маркетинговых и рекламных стратегий, которые направлены исключительно на эффективный и быстрый рост бизнеса.Better Robots.txt предоставляет список из 150+ инструментов, доступных в Интернете, чтобы ускорить ваш рост.

10. Robots.txt Post Meta Box для ручных исключений

Этот мета-блок сообщения позволяет установить «вручную», должна ли страница быть видимой (или нет) в поисковых системах, путем введения специального правила «запретить» + «noindex» в ваш файл robots.txt WordPress. Почему это полезно для вашего рейтинга в поисковых системах? Просто потому, что некоторые страницы не предназначены для сканирования / индексации. Страницы с благодарностью, целевые страницы, страницы, содержащие исключительно формы, полезны для посетителей, но не для поисковых роботов, и вам не нужно, чтобы они отображались в поисковых системах.Кроме того, некоторые страницы, содержащие динамические календари (для онлайн-бронирования), НИКОГДА не должны быть доступны для поисковых роботов, поскольку они имеют тенденцию заманивать их в бесконечные циклы сканирования, что напрямую влияет на ваш бюджет сканирования (и ваш рейтинг).

11. Возможность сканирования Ads.txt и App-ads.txt

Чтобы гарантировать, что файлы ads.txt и app-ads.txt могут сканироваться поисковыми системами, плагин Better Robots.txt гарантирует, что они по умолчанию разрешены в файле Robots.txt независимо от вашей конфигурации.Для вашей информации, авторизованные цифровые продавцы для Интернета или ads.txt — это инициатива IAB, направленная на повышение прозрачности программной рекламы. Вы можете создать свои собственные файлы ads.txt, чтобы определить, кто имеет право продавать ваши ресурсы. Файлы общедоступны и могут сканироваться биржами, платформами поставщиков (SSP) и другими покупателями и сторонними поставщиками. Авторизованные продавцы для приложений или app-ads.txt — это расширение стандарта авторизованных цифровых продавцов. Он расширяет совместимость для поддержки рекламы, отображаемой в мобильных приложениях.

Как всегда, еще впереди…

.

Robots.txt Editor — плагин для WordPress

Плагин позволяет создавать и редактировать файл robots.txt на вашем сайте.

Характеристики

- Работает с многосайтовой сетью на поддоменах;

- Пример правильного файла для WordPress;

- Работает «из коробки»;

- Совершенно бесплатно.

- Настройки Robots.txt

- Распакуйте загруженный zip-файл.

- Загрузите папку плагина в каталог

wp-content / plugins /вашего сайта WordPress. - Активируйте

Robots.txt Editorсо страницы плагинов

Отличный плагин «из коробки» как говорится. Без спама и апселлов, вообще ничего. Просто хорошо!

Такой полезный плагин для простого просмотра и редактирования содержимого Robots.txt.

Я не использую два плагина SEO, которые позволяют редактировать Robots.txt, и считаю использование FTP и Блокнота слишком громоздким / трудоемким.Вместо этого использование этого плагина сэкономит мне драгоценное время.

Так что спасибо за создание этого плагина!

Работает безупречно, сразу после установки и просто, так как не требует настройки.

Просто «поставил и забыл».

Легкий и идеальный для установки на нескольких площадках.

Но в документации нужно указать, где установлен параметр / редактор (Настройки> Параметры чтения).

Спасибо за плагин.Так приятно найти тот, который так легко использовать для нескольких сайтов. Надеюсь, вы будете обновлять плагин.

Очень простой и эффективный плагин

Посмотреть все 7 отзывов

«Редактор Robots.txt» — программа с открытым исходным кодом. Следующие люди внесли свой вклад в этот плагин.

авторов

1.1.3

Дата выпуска: 19 апр.2020 г.

- Совместимость с WordPress 5.4

1.1,2

Дата выпуска: 27 июля 2019 г.

- Добавить — совместимость с WordPress 5.2.2

1.1.1

Дата выпуска: 6 мая 2019 г.

- Улучшено — обнаружение карты сайта

1,1

Дата выпуска: 6 мая 2019 г.

- Добавить — просмотр ссылки в robots.txt

1,0

Дата выпуска: 2 мая 2019 г.

.

Virtual Robots.txt — плагин для WordPress

Virtual Robots.txt — это простое (то есть автоматизированное) решение для создания и управления файлом robots.txt для вашего сайта. Вместо того, чтобы возиться с FTP, файлами, разрешениями и т. Д., Просто загрузите и активируйте плагин, и все готово.

По умолчанию плагин Virtual Robots.txt разрешает доступ к тем частям WordPress, которые нужны хорошим ботам, таким как Google. Остальные части заблокированы.

Если плагин обнаруживает существующий файл карты сайта XML, ссылка на него будет автоматически добавлена в ваш файл robots.txt файл.

- Загрузить папку pc-robotstxt в каталог

/ wp-content / plugins / - Активируйте плагин через меню «Плагины» в WordPress

- После установки и активации плагина вы увидите новую ссылку меню Robots.txt в меню настроек. Щелкните эту ссылку меню, чтобы увидеть страницу настроек плагина. Оттуда вы можете редактировать содержимое вашего файла robots.txt.

Будет ли он конфликтовать с существующим robots.txt файл?

Если на вашем сайте существует физический файл robots.txt, WordPress не будет обрабатывать его запросы, поэтому конфликта не будет.

Будет ли это работать для установки WordPress в подпапках?

Из коробки, нет. Поскольку WordPress находится в подпапке, он не «узнает», когда кто-то запрашивает файл robots.txt, который должен находиться в корне сайта.

Изменяет ли этот плагин отдельные сообщения, страницы или категории?

Нет, не так.

Почему плагин по умолчанию блокирует определенные файлы и папки?

По умолчанию виртуальный файл robots.txt настроен на блокировку файлов и папок WordPress, к которым не требуется доступ поисковых систем. Конечно, если вы не согласны со значениями по умолчанию, вы можете легко их изменить.

Прекрасно работает, прост в использовании и настройке. Он уже установил по умолчанию каталоги, которые нужно исключить из сканирования / индексации поисковыми системами…

Очень им доволен!

То, что я увидел, было не тем, что я получил. XML-карта сайта не была включена в файл robots.txt, хотя это было описано как функция, которая должна работать из коробки. Кроме того, при установке этого плагина он без запроса блокировал определенные каталоги. Наконец, он вставляет строку вверху файла, продвигая плагин. Это должна быть дополнительная функция, которую пользователи могут отключить. В целом, он предлагает функциональные возможности, но не справляется и разочаровывает в других областях.

Я думал, это будет просто. Конечно, звучит просто.

Но после того, как я сохранил предложенный вами текст в моем новом «виртуальном robots.txt», я щелкнул ссылку, где говорится: «Вы можете предварительно просмотреть свой файл robots.txt здесь (открывается в новом окне). Если ваш файл robots.txt этого не делает» t соответствует тому, что показано ниже, вместо этого может отображаться физический файл «.

В этом новом окне отображается текст, который действительно отличается от текста плагина. Я понимаю, что это означает, что есть физические роботы.txt на моем сервере.

Итак, какой из них на самом деле будет использоваться?

Ваш FAQ предлагает следующее:

В: Будет ли он конфликтовать с существующим файлом robots.txt?

О: Если на вашем сайте существует физический файл robots.txt, WordPress не будет обрабатывать для него какие-либо запросы, поэтому конфликта не будет.

Если физический файл существует, WP не будет обрабатывать НИКАКИХ запросов на него?

Эти ЗВУКИ, такие как WP, будут игнорировать как физический файл, так и ваш виртуальный. В таком случае в чем смысл? Мне кажется, может и не быть.

Когда я вручную перехожу на mydomain.com / robots.txt, я вижу, что находится в физическом файле, а не то, что сохранил плагин.

Итак … это работает? Я не знаю!

Следует ли мне удалить физический файл и предположить, что виртуальный будет работать? Я не знаю!

Следует ли мне удалить этот плагин и отредактировать физический файл вручную? Более вероятный.

2 звезды вместо 1, потому что я ценю возможность включения предложенных строк в мой файл.

Мне нравится, что он такой чистый. Спасибо за создание!

Awesome, простое решение распространенной проблемы (менеджеры контента сайтов, которые хотят скрыть определенные страницы из результатов поиска Google).Небольшое примечание: в моем случае существующий файл Sitemap, созданный плагином «Google (XML) Sitemaps Generator» Арне Браххолда, не был обнаружен.

Посмотреть все 8 отзывов

«Virtual Robots.txt» — программное обеспечение с открытым исходным кодом. Следующие люди внесли свой вклад в этот плагин.

авторов

1,9

- Исправление для PHP 7. Спасибо SharmPRO.

1,8

- Отмена последних исправлений, поскольку они имели непредвиденные побочные эффекты.

1.7

- Дальнейшие исправления проблемы с удалением новой строки. Спасибо FAMC за отчет и исправление кода.

- После обновления посетите и повторно сохраните свои настройки и убедитесь, что они выглядят правильно.

1,6

- Исправлена ошибка, при которой удалялись новые строки. Спасибо FAMC за отчет.

1,5

- Исправлена ошибка, из-за которой плагин предполагал, что robots.txt будет находиться по адресу http, хотя он может находиться по адресу https. Спасибо jeffmcneill за сообщение.

1,4

- Исправлена ошибка ссылки на robots.txt, которая не настраивалась для установки подпапок WordPress.

- Обновлены директивы robots.txt по умолчанию в соответствии с последними практиками для WordPress.

- Разработка и поддержка плагина переданы Мариосу Александру.

1,3

- Теперь использует хук do_robots и проверяет is_robots () в действии плагина.

1,2

- Добавлена поддержка существующей карты сайта.xml.gz файл.

1,1

- Добавлена ссылка на страницу настроек, возможность удаления настроек.

1,0

.

Multisite Robots.txt Manager — плагин для WordPress

Плагин диспетчера Robots.txt для многосайтовых сетей WordPress. Быстро и легко управляйте всеми файлами robots.txt в многосайтовой сети веб-сайтов WordPress.

!!! Только для мультисайтовых установок с поддержкой сети !!!

Этот плагин был создан для многосайтовых сетей> Только сетевая активация!

Для поддержки и ошибок

Свяжитесь с нами напрямую, если вам нужна помощь или вы обнаружили ошибку.Форум поддержки WordPress не уведомляет нас о новых обращениях в службу поддержки, не знаю почему, поэтому свяжитесь с нами напрямую.

Просматривайте, сообщайте об ошибках, вносите свой вклад!

Посетите этот плагин на Github! Клонируйте / создайте копию, сообщите об ошибке или отправьте заявку и запрос на перенос!

Особенности:

- Общесетевой файл robots.txt, общий для всех сайтов.

- Добавить дополнительные данные файла robots.txt для каждого веб-сайта администратора.

- Создайте уникальные файлы robots.txt для каждого сетевого веб-сайта.

- Управляйте всеми веб-сайтами из области сетевого администрирования.

- Управляйте отдельным веб-сайтом через администраторов настроек веб-сайта.

- Автоматически сгенерированные URL-адреса файла Sitemap, путь загрузки и путь к теме.

- Массовое обновление всех веб-сайтов в сети в один клик.

- Быстро публикуйте файлы настроек robots.txt в сети.

- Сканируйте и очищайте старые данные плагина файла robots.txt для устранения конфликтов.

Краткая информация:

- Роботы по умолчанию для всей сети.txt НЕ является действующим файлом robots.txt.

- Если вы отключите плагин, никакие параметры не будут удалены, но файлы robots.txt больше не будут отображаться.

Если вы удалите этот плагин, все параметры и настройки будут удалены из базы данных для всех веб-сайтов.

Получите плагин: Загрузить> Установить> Активировать по сети

- Доступ к сети: администратор сети> вкладка настроек> ссылка на MS Robots.txt

- Доступ к веб-сайту: администратор веб-сайта> вкладка настроек> MS Robots.txt Ссылка

Заставьте его работать:

- Сетевой администратор: выберите либо «Опубликовать сетевой файл robots.txt на всех сетевых веб-сайтах», либо «Опубликовать сетевой файл robots.txt на сетевых веб-сайтах, участником которых вы являетесь», затем нажмите кнопку «Обновить настройки», чтобы опубликовать файлы robots.txt.

- Администратор веб-сайта: измените добавленный файл robots.txt (или создайте уникальный файл robots.txt для веб-сайта), затем нажмите кнопку «обновить правила веб-сайта», чтобы опубликовать свои изменения.

Произвольный раздел

Описание настроек по умолчанию

Когда вы впервые входите в админку плагина через сетевой администратор, отображаемый файл robots.txt является копией по умолчанию «только для сети».

Маркер сетевого приложения

Маркер {APPEND_WEBSITE_ROBOTSTXT} в файле Network Robots.txt заменяется правилами добавления уникального файла robots.txt веб-сайта. Используйте маркер в настроенных файлах сети robots.txt для автоматического добавления роботов веб-сайта.txt при обновлении сети.

Файлы Robots.txt в каталогах

Этот плагин БУДЕТ отображать файлы robots.txt в каталогах, однако

«Пауки» поисковых систем читают только файлы robots.txt, находящиеся в корневом каталоге веб-сайта. Пауки не читают файлы robots.txt в каталогах, например: domain.com/PATH-or-FOLDER/robots.txt НЕ является допустимым местоположением.

От Google: «Роботы.txt должен находиться в каталоге верхнего уровня хоста… ..Сканеры не будут проверять файлы robots.txt в подкаталогах ».

Тестирование файлов Robots.txt

- Используйте Инструменты Google для веб-мастеров, чтобы проверить файлы Robots.txt…. в Google минимум:

Войдите в свою учетную запись Google и получите доступ к функции «Вход в Инструменты для веб-мастеров». Выберите веб-сайт или добавьте веб-сайт….

На главной странице Инструментов для веб-мастеров щелкните нужный сайт.

- В разделе «Работоспособность» щелкните «Заблокированные URL-адреса».

- Если он еще не выбран, щелкните вкладку Test robots.txt.

- Скопируйте содержимое файла robots.txt и вставьте его в первое поле.

- В поле URL-адреса укажите сайт для проверки.

- В списке User-agent выберите нужных пользовательских агентов.

- https://developers.google.com/webmasters/control-crawl-index/docs/robots_txt

В сеть добавлен новый сайт

- Если все веб-сайты используют сохраненные сетевые файлы robots.txt, нажмите кнопку «Обновить настройки», чтобы скопировать файл robots.txt по умолчанию на все новые веб-сайты, которые у вас есть.

- на сайт: затем нажмите кнопку «обновить правила веб-сайта», чтобы скопировать файл robots.txt по умолчанию на этот веб-сайт.

Отключение

- Отключить веб-сайт: в админке подключаемого модуля веб-сайта для каждого уникального веб-сайта прокрутите вниз и установите флажок «Отключить сохраненный файл robots.txt…», затем нажмите кнопку отправки. Это отключит файл robots.txt только для веб-сайта, сделав роботов WordPress по умолчанию.txt отображение файла.

- Отключить через сеть: в панели администратора сетевого плагина прокрутите вниз и установите флажок «Отключить сохраненные файлы robots.txt…», затем нажмите кнопку отправки.

= предустановки

- Эта функция позволяет быстро копировать готовые файлы robots.txt и URL-адрес структуры карты сайта в сетевой файл robots.txt по умолчанию. Это действие не публикует файлы robots.txt в сети.

Рекомендуемые плагины для карты сайта

- Google XML Sitemaps: https: // wordpress.org / extension / plugins / google-sitemap-generator /