Полное руководство по файлу robots.txt для WordPress

WordPress

access_time

25 июля, 2018

hourglass_empty

6мин. чтения

Чтобы быть уверенным, что ваш сайт хорошо ранжируется в результатах поисковых систем (Search Engine Result Pages – SERPs), вам нужно сделать его наиболее важные страницы удобным для поиска и индексирования «роботоми» («ботами») поисковых движков. Хорошо структурированный файл robots.txt поможет направить этих ботов на страницы, которые вы хотите проиндексировать (и пропустить другие).

В этой статье мы собираемся раскрыть такие вопросы:

- Что такое файл robots.txt и почему он важен

- Где находится robots.txt для WordPress

- Как создать файл robots.txt

- Какие правила должны быть в файле robots.txt для WordPress

- Как проверить файл robots.txt и отправить его в консоль Google Search.

К концу нашего обсуждения у вас будет всё необходимое для настройки отличного файла robots.txt для вашего сайт на WordPress. Начнём!

Что такое файл

robots.txt для WordPress и зачем он нужен

Когда вы создаёте новый сайт, поисковые движки будут отправлять своих миньонов (или роботов) для сканирования и создания карты всех его страниц. Таким образом, они будут знать, какие страницы показывать как результат, когда кто-либо ищет по относящимся ключевым словам. На базовом уровне это достаточно просто.

Проблема состоит в том, что современные сайты содержат множество других элементом, кроме страниц. WordPress позволяет вам устанавливать, например, плагины, которые часто имеют свои каталоги. Вы не хотите показывать это в результатах поисковой выдачи, поскольку они не соответствуют содержимому.

Что делает файл robots.txt, так это обеспечивает ряд указаний для поисковых роботов. Он говорит им: «Посмотрите здесь, но не заходите в эти области!». Этот файл может настолько подробным, на сколько вы захотите и его очень просто создавать, даже если вы не технический волшебник.

Он говорит им: «Посмотрите здесь, но не заходите в эти области!». Этот файл может настолько подробным, на сколько вы захотите и его очень просто создавать, даже если вы не технический волшебник.

На практике, поисковые движки всё равно будут сканировать ваш сайт, даже если вы не создадите файл robots.txt. Однако, не создавать его является весьма нерациональным шагом. Без этого файла вы оставите роботам для индексации весь контент вашего сайта и они решать, что можно показывать все части вашего сайта, даже те, которые бы вы хотели скрыть от общего доступа.

Более важный момент, без файла robots.txt, у вас будет очень много обращений для сканирования ботами вашего сайта. Это негативно скажется на его производительности. Даже если посещаемость вашего сайта ещё невелика, скорость загрузки страницы – это то, что всегда должно быть в приоритете и на высшем уровне. В конце концов, есть всего несколько моментов, которые люди не любят больше, чем медленная загрузка сайтов.

Где находится файл robots.txt для WordPress

Когда вы создаёте сайт на WordPress, файл robots.txt создаётся автоматически и располагается в вашем главном каталоге на сервере. Например, если ваш сайт расположен здесь: yourfakewebsite.com, вы сможете найти его по адресу yourfakewebsite.com/robots.txt и увидеть примерно такой файл:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/

Это пример самого простого базового файла robots.txt. Переводя на понятный человеку язык, правая часть после User-agent: объявляет, для каких роботов предназначены правила ниже. Звёздочка означает, что правило универсальное и применяется для всех ботов. В данном случае файл говорит ботам, что им нельзя сканировать каталоги wp-admin и wp-includes. Смыл этих правил заключается в том, что данные каталоги содержат очень много файлов, требующих защиты от общего доступа.

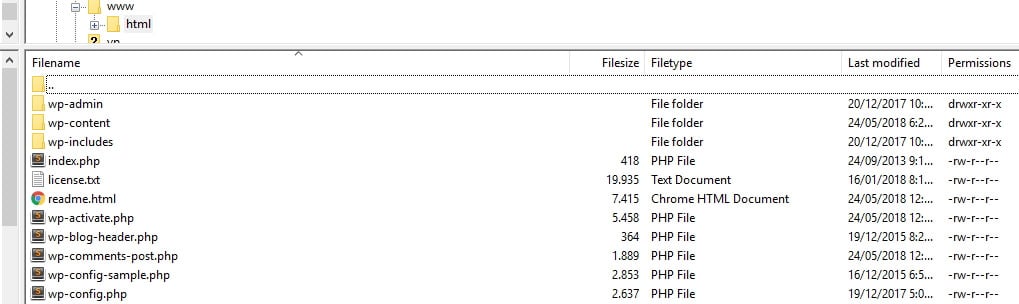

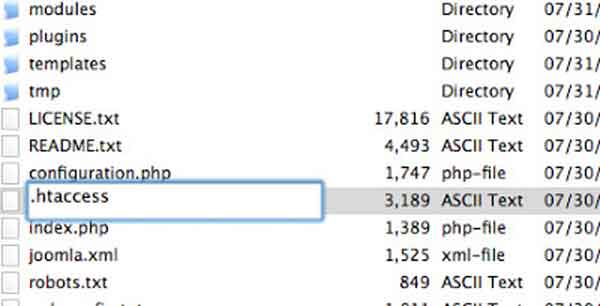

Конечно же, вы можете добавить больше правил в свой файл. Прежде чем вы это сделаете, вам нужно понять, что это виртуальный файл. Обычно, WordPress robots.txt находится в корневом(root) каталоге, который часто называется public_html или www (или по названию имени вашего сайта):

Надо отметить, что файл robots.txt для WordPress, устанавливаемый по умолчанию, не доступен для вас ни из какого каталога. Он работает, но если вы захотите внести изменения, вам нужно создать ваш собственный файл и загрузить его в корневой каталог в качестве замены.

Мы рассмотрим несколько способов создания файла robots.txt для WordPress за минуту. А сейчас давайте обсудим, как определить, какие правила нужно включить в файл.

Какие правила нужно включить в файл robots.txt для WordPress

В предыдущем разделе мы видели пример генерируемого WordPress файла robots.txt. Он включает в себя только два коротких правила, но для большинства сайтов их достаточно. Давайте взглянем на два разных файла robots.txt и рассмотрим, что каждый из них делает.

Вот наш первый пример файла robots.txt WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: /checkout/ Disallow: /images/ Disallow: /forum/

Этот файл robots.txt создан для форума. Поисковые системы обычно индексируют каждое обсуждение на форуме. В зависимости от того, какая тематика вашего форума, вы можете захотеть запретить индексацию. Так, например, Google не будет индексировать сотни коротких обсуждения пользователей. Вы также можете установить правила, указывающие на конкретную ветвь форума, чтобы исключить её, и позволить поисковым системам обходить остальные.

Вы также заметили строку, которая начинается с Allow: / вверху файла. Эта строка говорит ботам, что они могут сканировать все страницы вашего сайта, кроме установленных ниже ограничений. Также вы заметили, что мы установили эти правила как универсальные (со звёздочкой), как было в виртуальном файле WordPress robots.txt.

Эта строка говорит ботам, что они могут сканировать все страницы вашего сайта, кроме установленных ниже ограничений. Также вы заметили, что мы установили эти правила как универсальные (со звёздочкой), как было в виртуальном файле WordPress robots.txt.

Давайте проверим другой пример файла WordPress robots.txt:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ User-agent: Bingbot Disallow: /

В этом файле мы устанавливаем те же правила, что идут в WordPress по умолчанию. Хотя мы также добавляем новый набор правил, которые блокируют поисковых роботов Bing от сканирования нашего сайта. Bingbot, как можно понять, это имя робота.

Вы можете совершенно конкретно задавать поисковых роботов отдельного движка для ограничения/разрешения их доступа. На практике, конечно, Bingbot очень хороший (даже если не такой хороший, как Googlebot). Однако, есть и много вредоносных роботов.

Плохой новостью является то, что они далеко не всегда следуют инструкциям из файла robots.txt (они же всё же работают как террористы). Следует иметь в виду, что, хотя большинство роботов будут использовать указания, представленные в этом файле, но вы не можете принудить их это делать. Мы просто хорошо просим.

Если глубже вникнуть в тему, вы найдёте много предложений того, что разрешать и что блокировать на своём сайте WordPress. Хотя, из нашего опыта, меньше правил часто лучше. Вот пример рекомендованного вида вашего первого файла robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/

Традиционно WordPress любит закрывать каталоги wp-admin и wp-includes. Однако, это уже не является лучшим решением. Плюс, если вы добавляете мета тэги для своих изображений с целью продвижения (SEO), нету смысла указывать ботам не отслеживать содержимое этих каталогов. Вместо этого, два правила выше обеспечивают основные потребности большинства сайтов.

Что содержится в вашем файле robots.txt будет зависеть от особенностей и потребностей вашего сайта. Поэтому смело проводите больше исследований!

Как создать файл robots.txt для WordPress (3 способа)

Как только вы решили сделать свой файл robots.txt, всё что осталось – это найти способ его создать. Вы можете редактировать robots.txt в WordPress, используя плагин или вручную. В этом разделе мы обучим вас применению двух наиболее популярных плагинов для выполнения этой задачи и обсудим, как создать и загрузить файл вручную. Поехали!

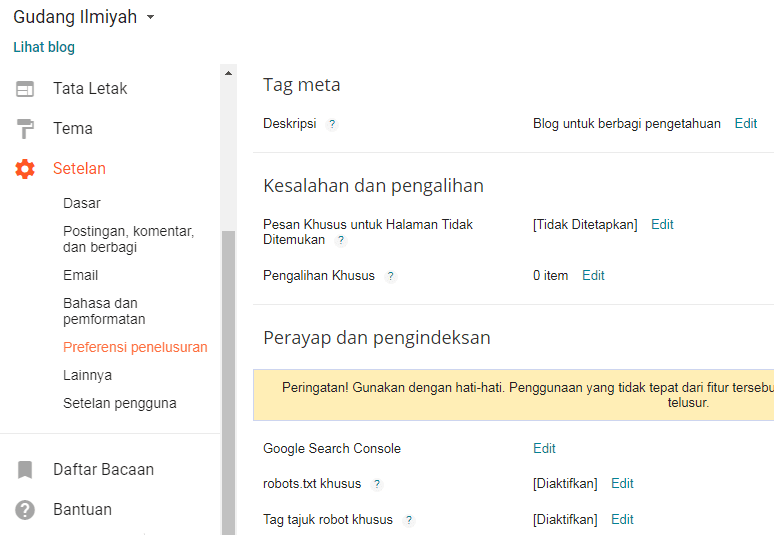

1. Использование плагина Yoast SEO

Yoast SEO вряд ли требует представления. Это наиболее известный SEO-плагин для WordPress, он позволяет вам улучшать ваши записи и страницы для лучшего использования ключевых слов. Кроме этого, он также оценит ваш контент с точки зрения удобности чтения, а это повысит аудиторию поклонников.

Наша команда является почитателями плагина Yoast SEO благодаря его простоте и удобству. Это относится и к вопросу создания файла robots.txt. Как только вы установите и активируете свой плагин, перейдите во вкладку SEO › Инструменты в своей консоли и найдите настройку Редактор файлов:

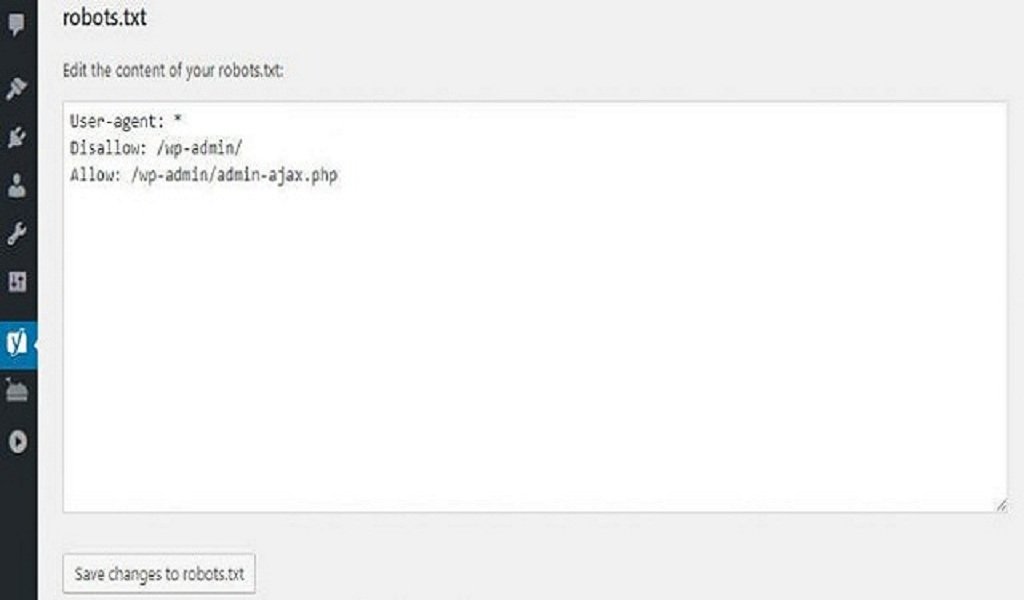

Нажав на эту ссылку, вы можете редактировать файл .htaccess не покидая админ консоль. Здесь же есть кнопка Создать файл robots.txt:

После нажатия на кнопку во вкладке будет отображён новый редактор, где вы можете напрямую редактировать ваш файл robots.txt. Обратите внимание, что Yoast SEO устанавливает свои правила по умолчанию, которые перекрывают правила существующего виртуального файла robots.txt.

После удаления или добавления правил нажимайте кнопку Сохранить изменения в robots.txt для вступления их в силу:

Это всё! Давайте теперь посмотрим на другой популярный плагин, который позволит нам выполнить эту же задачу.

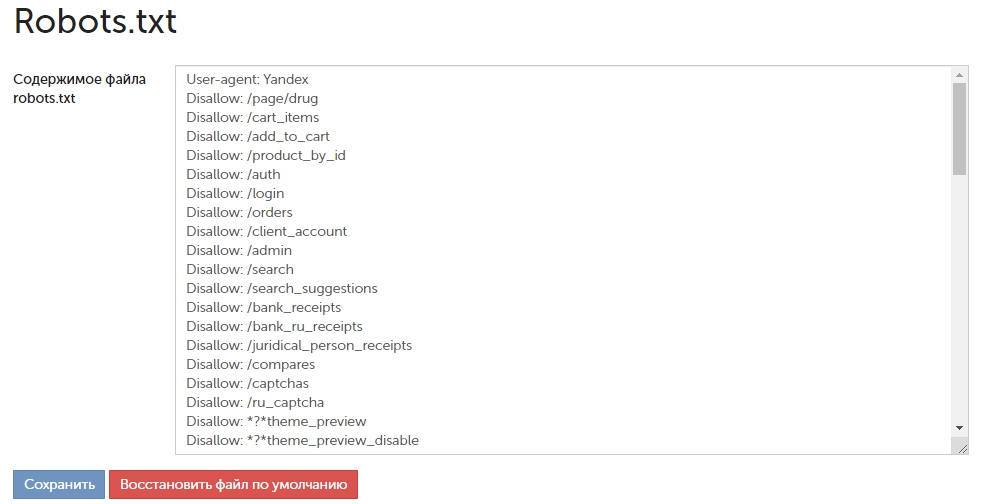

2. Применение плагина All in One SEO Pack

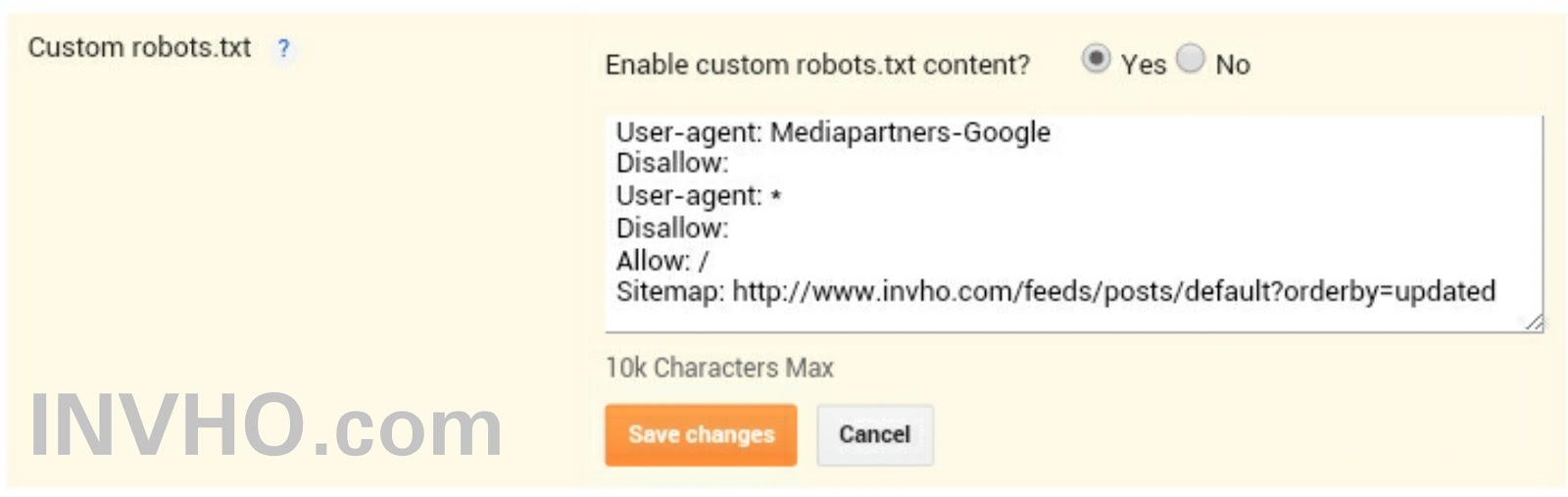

Плагин All in One SEO Pack – ещё один прекрасный плагин WordPress для настройки SEO. Он включает в себя большинство функций плагина Yoast SEO, но некоторые предпочитают его потому что он более легковесный. Что касается файла robots.txt, его создать в этом плагине также просто.

После установки плагина, перейдите на страницу All in One SEO > Управление модулями в консоли. Внутри вы найдёте опцию Robots.txt с хорошо заметной кнопкой Activate внизу справа. Нажмите на неё:

Теперь в меню All in One SEO будет отображаться новая вкладка Robots.txt. Если вы нажмёте на этот пункт меню, вы увидите настройки для добавления новых правил в ваш файл, сохраните внесённые изменения или удалите всё:

Обратите внимание, что вы не можете напрямую изменять файл robots.txt при помощи этого плагина. Содержимое файла будет неактивным, что видно по серому фону поля, в отличие от Yoast SEO, который позволяет вам вводить всё, что вы хотите:

Но, так как добавление новых правил очень простая процедура, то этот факт не должен расстроить вас. Более важный момент, что All in One SEO Pack также включает функцию, которая поможет вам блокировать «плохих» ботов, её вы можете найти во вкладке All in One SEO:

Это всё, что вам нужно сделать, если вы выбрали этот способ. Теперь давайте поговорим о том, как вручную создать файл robots.txt, если вы не хотите устанавливать дополнительный плагин только для этой задачи.

3. Создание и загрузка файла

robots.txt для WordPress по FTP

Что может быть проще, чем создание текстового файла txt. Всё, что вам нужно сделать, открыть свой любимый редактор (как, например, Notepad или TextEdit) и ввести несколько строк. Потом вы сохраняете файл, используя любое имя и расширение txt. Это буквально займёт несколько секунд, поэтому вы вполне можете захотеть создать robots.txt для WordPress без использования плагина.

Это буквально займёт несколько секунд, поэтому вы вполне можете захотеть создать robots.txt для WordPress без использования плагина.

Вот быстрый пример такого файла:

Мы сохранили этот файл локально на компьютере. Как только вы сделали свой собственный файл вам нужно подключиться к своему сайту по FTP. Если вы не совсем понимаете, как это сделать, у нас есть руководство, посвящённое этому – использование удобного для новичков клиента FileZilla.

После подключения к своему сайту перейдите в каталог public_html. Теперь, всё что вам нужно сделать это загрузить файл robots.txt со своего компьютера на сервер. Вы можете это сделать либо нажав правой кнопкой мыши на файле в локальной FTP навигаторе или простым перетаскиванием мышью:

Это займёт всего несколько секунд. Как вы видите, этот способ не сложнее использования плагина.

Как проверит WordPress robots.txt и отправить его в Консоль Google Search

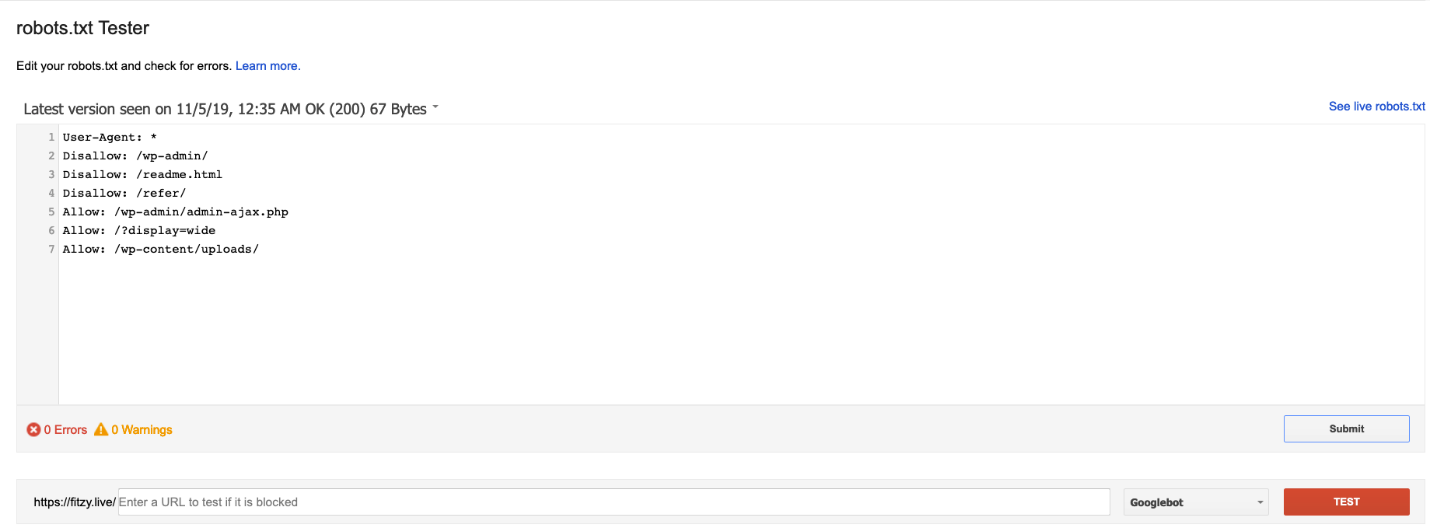

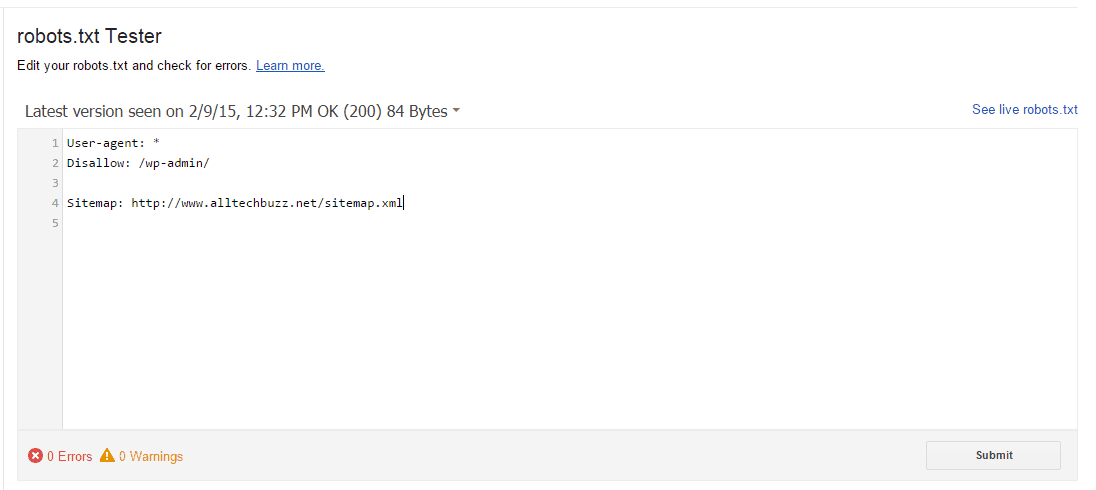

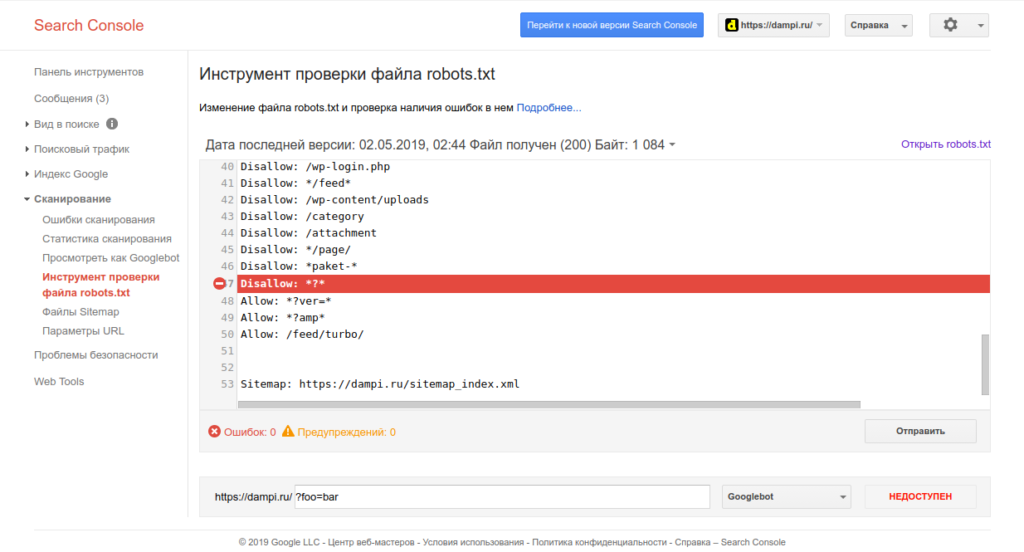

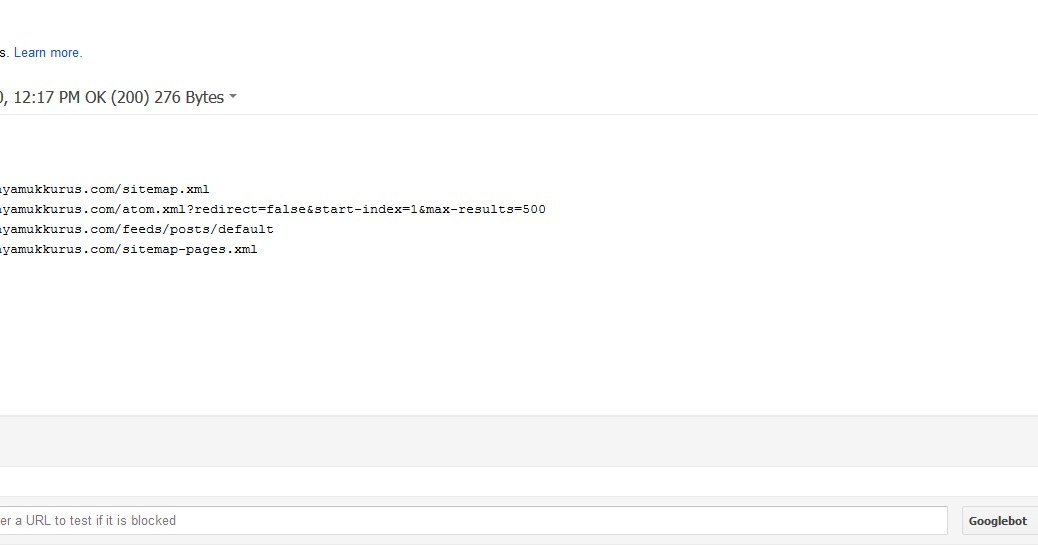

Теперь, когда ваш файл WordPress robots.txt создан и загружен на сайт, вы можете проверить его на ошибки в Консоли Google Search. Search Console – это набор инструментов Google, призванных помочь вам отслеживать то, как ваш контент появляется в результатах поиска. Один из таких инструментов проверяет robots.txt, его вы можете использовать перейдя в своей консоли в раздел Инструмент проверки файла robots.txt:

Здесь вы найдёте поле редактора, где вы можете добавить код своего файла WordPress robots.txt, и нажать Отправить в правом нижнем углу. Консоль Google Search спросит вас, хотите ли вы использовать новый код или загрузить файл с вашего сайта. Выберите опцию, которая говорит Ask Google to Update для публикации вручную:

Теперь платформа проверит ваш файл на ошибки. Если будет найдена ошибка, информация об этом будет показана вам.

Вы ознакомились с несколькими примерами файл robots. index\.php$ — [L]

index\.php$ — [L]

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

</IfModule>

# BEGIN W3TC Browser Cache

<IfModule mod_deflate.c>

<IfModule mod_headers.c>

Header append Vary User-Agent env=!dont-vary

</IfModule>

AddOutputFilterByType DEFLATE text/css text/x-component application/x-javascript application/javascript text/javascript text/x-js text/html text/richtext image/svg+xml text/plain text/xsd text/xsl text/xml image/bmp application/java application/msword application/vnd.ms-fontobject application/x-msdownload image/x-icon application/json application/vnd.ms-access application/vnd.ms-project application/x-font-otf application/vnd.ms-opentype application/vnd.oasis.opendocument.database application/vnd.oasis.opendocument.chart application/vnd.oasis.opendocument.formula application/vnd.oasis.opendocument.graphics application/vnd.oasis.opendocument.presentation application/vnd.oasis.opendocument.spreadsheet application/vnd.oasis.opendocument.text audio/ogg application/pdf application/vnd.ms-powerpoint application/x-shockwave-flash image/tiff application/x-font-ttf application/vnd.ms-opentype audio/wav application/vnd.ms-write application/font-woff application/font-woff2 application/vnd.ms-excel

<IfModule mod_mime.c>

# DEFLATE by extension

AddOutputFilter DEFLATE js css htm html xml

</IfModule>

</IfModule>

<FilesMatch «\.(bmp|class|doc|docx|eot|exe|ico|json|mdb|mpp|otf|_otf|odb|odc|odf|odg|odp|ods|odt|ogg|pdf|pot|pps|ppt|pptx|svg|svgz|swf|tif|tiff|ttf|ttc|_ttf|wav|wri|woff|woff2|xla|xls|xlsx|xlt|xlw|BMP|CLASS|DOC|DOCX|EOT|EXE|ICO|JSON|MDB|MPP|OTF|_OTF|ODB|ODC|ODF|ODG|ODP|ODS|ODT|OGG|PDF|POT|PPS|PPT|PPTX|SVG|SVGZ|SWF|TIF|TIFF|TTF|TTC|_TTF|WAV|WRI|WOFF|WOFF2|XLA|XLS|XLSX|XLT|XLW)$»>

<IfModule mod_headers.c>

Header unset Last-Modified

</IfModule>

</FilesMatch>

# END W3TC Browser Cache

# BEGIN W3TC CDN

<FilesMatch «\. index\.php$ — [L]

index\.php$ — [L]

RewriteCond %{REQUEST_FILENAME} !-f

RewriteCond %{REQUEST_FILENAME} !-d

RewriteRule . /index.php [L]

</IfModule>

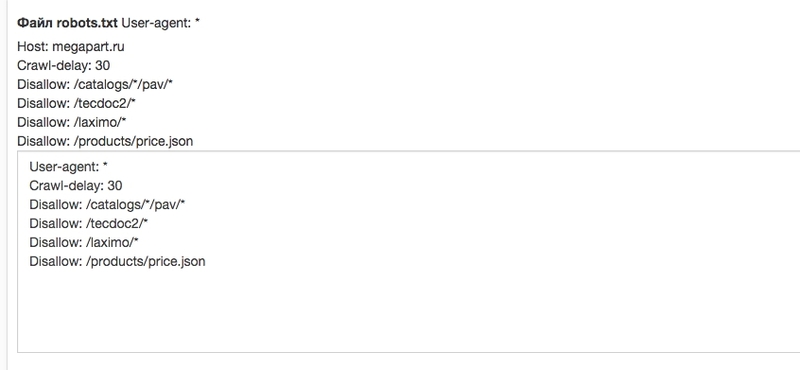

Как посмотреть robots.txt сайта, который вам интересен?

От автора: хотите составить для своего проекта файл с указаниями для робота, но не знаете как? Сегодня разберемся, как посмотреть robots.txt сайта и изменить его под свои нужды.

В интернете каждый день появляются готовые решения по той или иной проблеме. Нет денег на дизайнера? Используйте один из тысяч бесплатных шаблонов. Не хотите нанимать сео-специалиста? Воспользуйтесь услугами какого-нибудь известного бесплатного сервиса, почитайте сами пару статей.

Уже давно нет необходимости самому с нуля писать тот же самый robots.txt. К слову, это специальный файл, который есть практически на любом сайте, и в нем содержатся указания для поисковых роботов. Синтаксис команд очень простой, но все равно на составление собственного файла уйдет время. Лучше посмотреть у другого сайта. Тут есть несколько оговорок:

Сайт должен быть на том же движке, что и ваш. В принципе, сегодня в интернете куча сервисов, где можно узнать название cms практически любого веб-ресурса.

Это должен быть более менее успешный сайт, у которого все в порядке с поисковым трафиком. Это говорит о том, что robots.txt составлен нормально.

Практический курс по верстке адаптивного сайта с нуля!

Изучите курс и узнайте, как верстать современные сайты на HTML5 и CSS3

Узнать подробнее

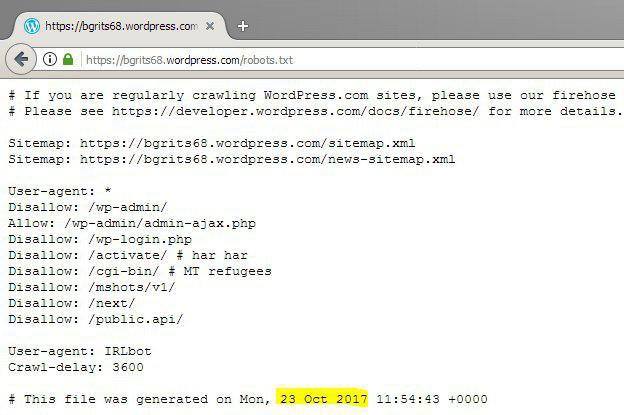

Итак, чтобы посмотреть этот файл нужно в адресной строке набрать: доменное-имя.зона/robots.txt

Все неверятно просто, правда? Если адрес не будет найден, значит такого файла на сайте нет, либо к нему закрыт доступ. Но в большинстве случаев вы увидите перед собой содержимое файла:

В принципе, даже человек не особо разбирающийся в коде быстро поймет, что тут написать. Команда allow разрешает что-либо индексировать, а disallow – запрещает. User-agent – это указание поисковых роботов, к которым обращены инструкции. Это необходимо в том случае, когда нужно указать команды для отдельного поисковика.

User-agent – это указание поисковых роботов, к которым обращены инструкции. Это необходимо в том случае, когда нужно указать команды для отдельного поисковика.

Что делать дальше?

Скопировать все и изменить под свой сайт. Как изменять? Я уже говорил, что движки сайтов должны совпадать, иначе изменять что-либо бессмысленно – нужно переписывать абсолютно все.

Итак, вам необходимо будет пройтись по строкам и определить, какие разделы из указанных присутствуют на вашем сайте, а какие – нет. На скриншоте выше вы видите пример robots.txt для wordpress сайта, причем в отдельном каталоге есть форум. Вывод? Если у вас нет форума, все эти строки нужно удалить, так как подобных разделов и страниц у вас просто не существует, зачем тогда их закрывать?

Самый простой robots.txt может выглядеть так:

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content

Allow: /wp-content/uploads/

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content Allow: /wp-content/uploads/ |

Практический курс по верстке адаптивного сайта с нуля!

Изучите курс и узнайте, как верстать современные сайты на HTML5 и CSS3

Узнать подробнее

Все вы наверняка знаете стандартную структуру папок в wordpress, если хотя бы 1 раз устанавливали этот движок. Это папки wp-admin, wp-content и wp-includes. Обычно все 3 закрывают от индексации, потому что они содержат чисто технические файлы, необходимые для работы движка, плагинов и шаблонов.

Каталог uploads открывают, потому что в нем содержаться картинки, а их обыно индексируют.

В общем, вам нужно пройтись по скопированному robots.txt и просмотреть, что из написанного действительно есть на вашем сайте, а чего нет. Конечно, самому определить будет трудно. Я могу лишь сказать, что если вы что-то не удалите, то ничего страшного, просто лишняя строчка будет, которая никак не вредит (потому что раздела нет).

Так ли важна настройка robots.txt?

Конечно, необходимо иметь этот файл и хотя бы основные каталоги через него закрыть. Но критично ли важно его составление? Как показывает практика, нет. Я лично вижу сайты на одних движках с абсолютно разным robots.txt, которые одинаково успешно продвигаются в поисковых системах.

Я не спорю, что можно совершить какую-то ошибку. Например, закрыть изображения или оставить открытым ненужный каталог, но чего-то супер страшного не произойдет. Во-первых, потому что поисковые системы сегодня умнее и могут игнорировать какие-то указание из файла. Во-вторых, написаны сотни статей о настройке robots.txt и уж что-то можно понять из них.

Я видел файлы, в которых было 6-7 строчек, запрещающих индексировать пару каталогов. Также я видел файлы с сотней-другой строк кода, где было закрыто все, что только можно. Оба сайта при этом нормально продвигались.

В wordpress есть так называемые дубли. Это плохо. Многие борятся с этим с помощью закрытия подобных дублей так:

Disallow: /wp-feed

Disallow: */trackback

Disallow: */feed

Disallow: /tag/

Disallow: /archive/

Disallow: /wp-feed Disallow: */trackback Disallow: */feed Disallow: /tag/ Disallow: /archive/ |

Это лишь некоторые из дублей, создаваемых wordpress. Могу сказать, что так можно делать, но защиты на 100% ожидать не стоит. Я бы даже сказал, что вообще не нужно ее ожидать и проблема как раз в том, о чем я уже говорил ранее:

Поисковые системы все равно могут забрать в индекс такие вещи.

Тут уже нужно бороться по-другому. Например, с помощью редиректов или плагинов, которые будут уничтожать дубли. Впрочем, это уже тема для отдельной статьи.

Где находится robots.txt?

Этот файл всегда находится в корне сайта, поэтому мы и можем обратиться к нему, прописав адрес сайта и название файла через слэш. По-моему, тут все максимально просто.

В общем, сегодня мы рассмотрели вопрос, как посмотреть содержимое файла robots.txt, скопировать его и изменить под свои нужды. О настройке я также напишу еще 1-2 статьи в ближайшее время, потому что в этой статье мы рассмотрели не все. Кстати, также много информации по продвижению сайтов-блогов вы можете найти в нашем курсе. А я на этом пока прощаюсь с вами.

Практический курс по верстке адаптивного сайта с нуля!

Изучите курс и узнайте, как верстать современные сайты на HTML5 и CSS3

Узнать подробнее

Хотите узнать, что необходимо для создания сайта?

Посмотрите видео и узнайте пошаговый план по созданию сайта с нуля!

Смотреть

Правильный robots.txt для WordPress

Правильно созданный файл robots.txt способствует быстрой индексации страниц сайта. Этот файл является служебным и призван улучшать поисковую оптимизацию сайта. Внутренняя оптимизация страниц сайта на WordPress также немаловажна для проекта и ею нужно заниматься.

Файл robots.txt позволяет ограничить индексацию тех страниц, которые индексировать не нужно. Поисковые роботы обращают внимание на этот служебный файл с целью запрета показа страниц в поисковых системах, которые закрыты от индексации. Кстати, в файле также указываются карта сайта и его зеркало.

Как создать robots.txt для WordPress

Чтобы приступить к созданию правильного файла, для начала давайте поймем, где находится robots.txt WordPress. Он располагается в корне сайта. Чтобы просмотреть корневые папки и файлы вашего проекта, необходимо воспользоваться любым FTP-клиентом, для этого просто нужно нажать на настроенное «Соединение».

Чтобы посмотреть содержимое нашего служебного файла, достаточно просто набрать в адресной строке после имени сайта robots.txt. Пример: https://mysite.com/robots.txt

WordPress robots.txt где лежит вы знаете, осталось взглянуть, как должен выглядеть идеальный служебный файл для указанного выше движка.

- В первую очередь в файле необходимо указать пусть к карте сайта:

Sitemap: http://web-profy.com/sitemap.xml

- А теперь непосредственно правильная структура файла robots.txt для WordPress:

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: mysite.com

Sitemap: http://mysite.com/sitemap.xml.gz

Sitemap: http://mysite.com/sitemap.xml

Достаточно просто скопировать эти данные в свой файл. Так выглядит правильный robots.txt для WordPress.

Теперь рассмотрим, что означает каждая из строк в структуре служебного файла:

User-agent: * — строка, которая показывает, что все введенные ниже данные будут применимы относительно всех поисковых систем.

Однако для Яндекса правило будет выглядеть следующим образом: User-agent: Yandex.

Allow: — страницы, которые поисковые роботы могут индексировать.

Disallow: — страницы, которые поисковым роботам индексировать запрещено.

Host: mysite.com — зеркало сайта, которое нужно указывать в данном служебном файле.

Sitemap: — путь к карте сайта.

robots.txt для сайта WordPress, на котором не настроены ЧПУ

robots.txt для сайта WordPress, где находится список правил будет выглядеть несколько иначе в случае, если на сайте не настроены ЧПУ.

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /tag

Host: mysite.com

Sitemap: http://mysite.com /sitemap.xml.gz

Sitemap: http://mysite.com /sitemap.xml

Какие могут возникнуть проблемы на WordPress сайте, если нет настроены ЧПУ. Строка в служебном файле robots.txt Disallow: /*?* не позволяет индексировать страницы сайта, а именно так выглядят адреса страниц проекта при отсутствии настроек ЧПУ. Это может негативно отражаться на рейтинге интернет-проекта в поисковиках, поскольку нужный пользователям контент просто не будет им показываться в результатах выдачи.

Конечно, эту строку можно в файле можно легко удалить. Тогда сайт будет работать в нормальном режиме.

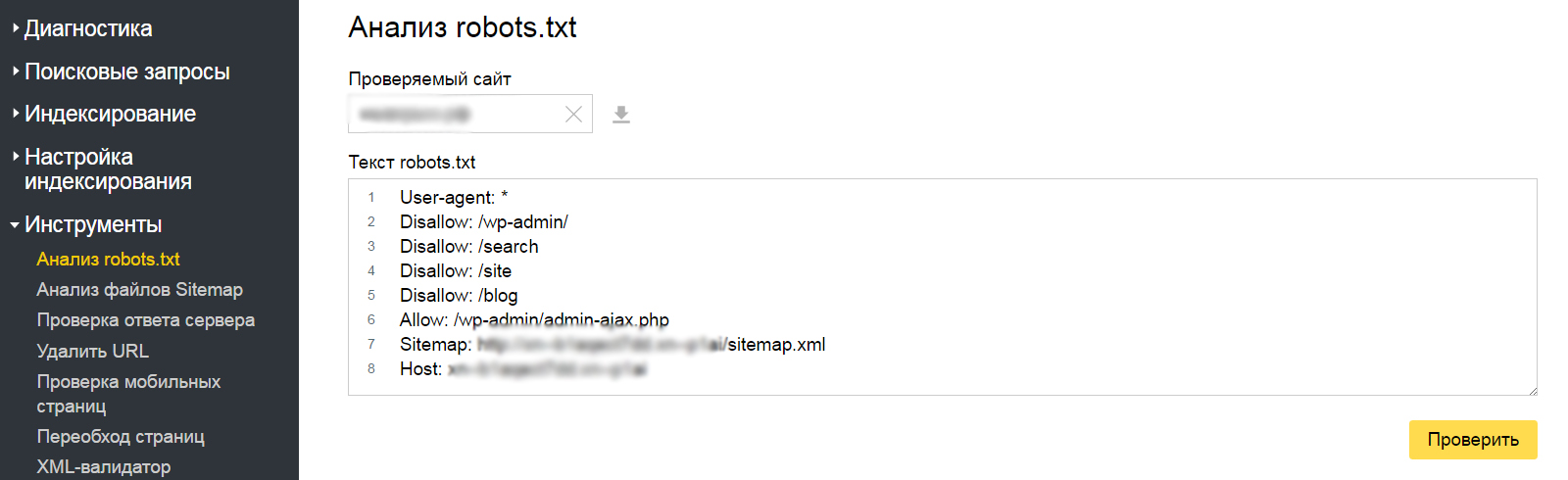

Как убедиться в том, что robots.txt составлен правильно

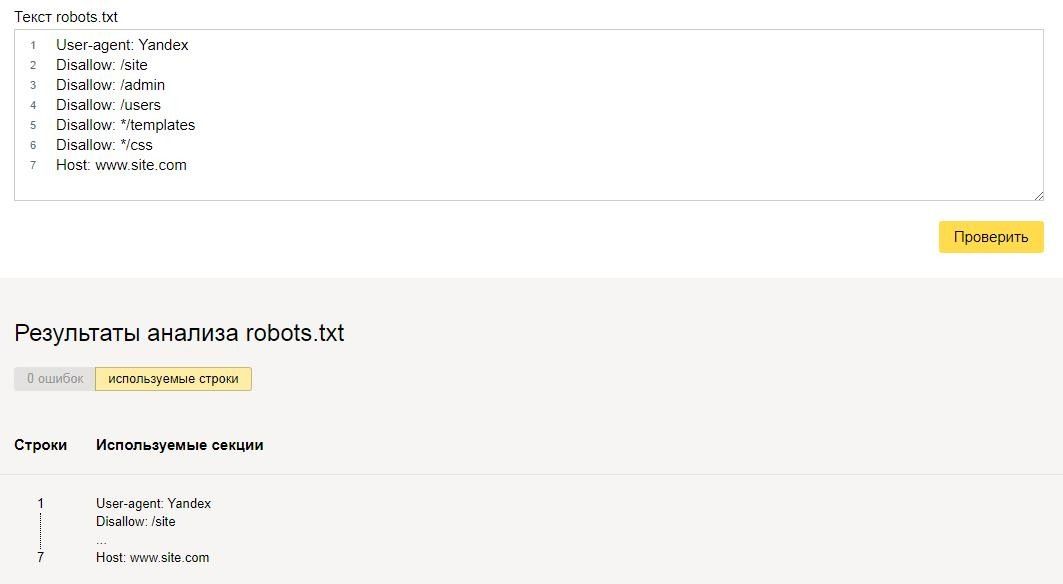

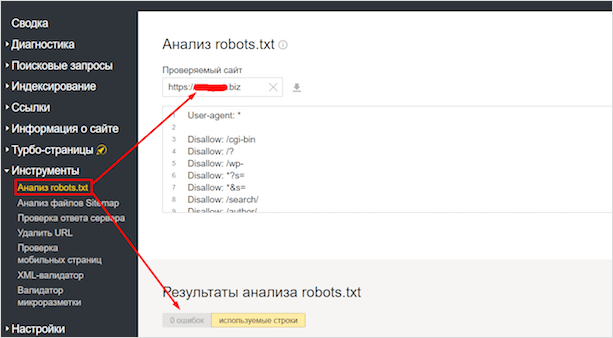

Сделать это можно при помощи специального инструмента от Яндекс — Яндекс.Вебмастер.

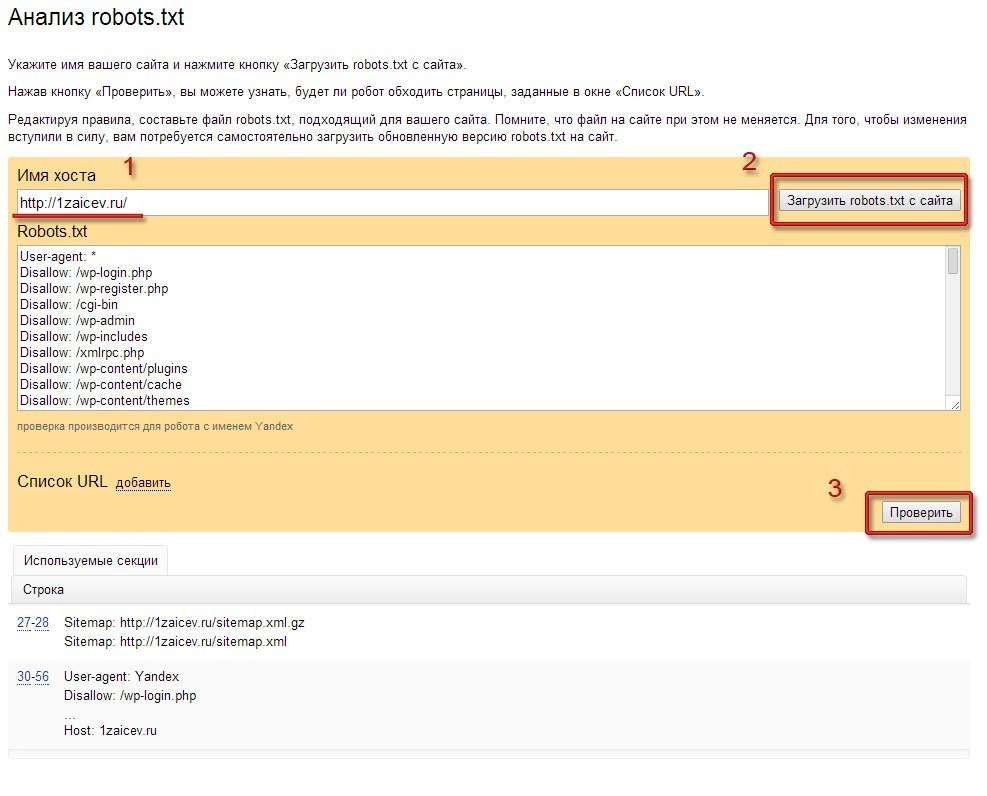

Необходимо зайти в Настройки индексирования — Анализ robots.txt

Внутри все интуитивно понятно. Необходимо нажать на «Загрузить robots.txt с сайта». Также вы можете каждую страницу отдельно просмотреть на наличие возможности ее индексации. В «Список URL» можно просто ввести адрес интересующих вас страниц, система покажет все сама.

Не стоит забывать о том, что все изменения, которые вы вносите в файл robots.txt, будут доступны не сразу, а спустя лишь несколько месяцев.

Как правильно сохранять файл robots.txt

Чтобы наш служебный файл был доступен в такой поисковой системе, как Google, его необходимо сохранить следующим образом:

- Файл в обязательном порядке должен иметь текстовый формат;

- Разместить его необходимо корне вашего сайта;

- Файл должен иметь имя robots.txt и никакое другое больше.

Адрес, по которому поисковые роботы находят robots.txt должен иметь следующий вид — https://mysite.com/robots.txt

Правильный robots.txt для WordPress

Относительно того, что должно быть внутри файла robots.txt до сих пор возникает куча споров. Вообще, на мой взгляд, этот файл должен содержать две обязательные вещи:

Скрывать в нём все функциональные PHP-файлы (как делают некоторые вебмастера) я не вижу смысла. А уж страницы сайта тем более. Я проводил эксперимент со скрытием страниц через robots.txt — они всё равно попали в индекс, но только без заголовка и без сниппета.

Для скрытия от индексации страниц сайта используйте метатег:

<meta name="robots" content="noindex, follow" />

Функция do_robots()

Выводит несколько директив для файла robots.txt, рекомендуемые для WordPress.

Параметров не имеет, зато имеет 1 хук и 1 фильтр.

Рассмотрим по порядку, как работает функция:

- В первую очередь функция устанавливает

Content-Typeдокумента наtext/plain(с кодировкой UTF-8). - Затем запускается экшен

do_robotstxt(без параметров). - Третьим шагом идёт проверка, отмечена ли галочка «Попросить поисковые системы не индексировать сайт» в настройках чтения:

- Если отмечена, содержимое

robots.txtбудет:User-agent: * Disallow: /

Если не отмечена:

User-agent: * Disallow: /wp-admin/

- Непосредственно перед выводом срабатывает фильтр

robots_txt(WordPress 3. 0+) с двумя параметрами —

0+) с двумя параметрами — $output(то, что подготовлено для вывода вrobots.txt) и$public(отмечена ли галочка в пункте 3).

Готовый robots.txt

К результату функции do_robots() добавим еще то, о чем я говорил в начале поста и получим вот такой robots.txt для WordPress:

User-agent: * Disallow: /wp-admin/ User-agent: Yandex Disallow: /wp-admin/ Host: truemisha.ru Sitemap: https://misha.agency/sitemap.xml

Создать его вы можете при помощи любого текстового редактора. Сохраните его там же, где находятся директории wp-admin и wp-content.

Миша

Недавно я осознал, что моя миссия – способствовать распространению WordPress. Ведь WordPress – это лучший движок для разработки сайтов – как для тех, кто готов использовать заложенную структуру этой CMS, так и для тех, кто предпочитает headless решения.

Сам же я впервые познакомился с WordPress в 2009 году. Организатор WordCamp. Преподаватель в школах Epic Skills и LoftSchool.

Если вам нужна помощь с вашим сайтом или может даже разработка с нуля на WordPress / WooCommerce — пишите. Я и моя команда сделаем вам всё на лучшем уровне.

Правильный файл robots.txt для WordPress 2020: настройка

Автор Анита Арико На чтение 15 мин. Просмотров 710 Опубликовано

Чтобы нужные страницы сайта попадали в индекс поисковых систем, важно правильно настроить файл robots.txt. Этот документ дает рекомендации поисковым роботам, какие страницы обрабатывать, а какие — нет: например, от индексации можно закрыть панель управления сайтом или страницы, которые находятся в разработке. Рассказываем, как правильно настроить robots.txt, если ваш сайт сделан на WordPress.

Что такое robots.txt и для чего он нужен?

Чтобы понять, какие страницы есть на сайте, поисковики «напускают» на него роботов: они сканируют сайт и передают перечень страниц в поисковую систему. robots.txt — это текстовый файл, в котором содержатся указания о том, какие страницы можно, а какие нельзя сканировать роботам.

robots.txt — это текстовый файл, в котором содержатся указания о том, какие страницы можно, а какие нельзя сканировать роботам.

Обычно на сайте есть страницы, которые не должны попадать в выдачу: например, это может быть административная панель, личные страницы пользователей или временные страницы сайта. Кроме этого, у поисковых роботов есть определенный лимит сканирования страниц (кроулинговый бюджет) — за раз они могут обработать только ограниченное их количество.

Проведем аналогию: представим сайт в виде города, а страницы в виде домов. По дорогам между домов ездят роботы и записывают информацию о каждом доме (индексируют страницы и добавляют в базу). Роботы получают ограниченное количество топлива в день — например, 10 литров на объезд города в день. Это топливо — кроулинговый бюджет, который выделяют поисковые системы на обработку сайта.

На маленьких проектах, 500-1000 страниц, кроулинговый бюджет не сказывается критично, но на интернет-магазинах, маркетплейсах, больших сервисах могут возникнут проблемы. Если они спроектированы неверно, то робот может месяцами ездить по одному кварталу (сканировать одни и те же страницы), но не заезжать в отдаленные районы. Чем больше проект, тем больший кроулинговый бюджет выделяют поисковики, но это не поможет, если дороги сделаны неудобно и вместо прямой дороги в 1 км нужно делать крюк в 15 км.

Правильный robots.txt помогает решить часть этих проблем.

Разные поисковые системы по-разному обрабатывают robots.txt: например, Google может включить в индекс даже ту страницу, которая запрещена в этом файле, если найдет ссылку на такую страницу на страницах сайта. Яндекс же относится к robots.txt как к руководству к действию — если страница запрещена для индексации в файле, она не будет включена в результаты поиска, но с момента запрета может пройти до двух недель до исключения из индекса. Таким образом, правильная настройка robots.txt в 99% случаев помогает сделать так, чтобы в индекс попадали только те страницы, которые вы хотите видеть в результатах поиска.

Кроме этого, robots.txt может содержать технические сведения о сайте: например, главное зеркало, местоположение sitemap.xml или параметры URL-адресов, передача которых не влияет на содержимое страницы.

Файл robots.txt рекомендует роботам поисковых систем, как правильно обрабатывать страницы сайта, чтобы они попали в выдачу.

Где находится файл robots.txt?

По умолчанию в WordPress нет файла robots.txt. При установке WordPress создает виртуальный файл robots.txt с таким содержимым:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpТакая настройка говорит поисковым роботам следующее:

User-agent: * — для любых поисковых роботов

Disallow: /wp-admin/ — запретить обрабатывать /wp-admin/

Allow: /wp-admin/admin-ajax.php — разрешить обрабатывать элементы сайта, которые загружаются через AJAX

Этот файл не получится найти в папках WordPress — он работает, но физически его не существует. Поэтому, чтобы настроить robots.txt, сначала нужно его создать.

Robots.txt должен находиться в корневой папке (mysite.ru/robots.txt), чтобы роботы любых поисковых систем могли его найти.

Как редактировать и загружать robots.txt

Есть несколько способов создать файл robots.txt — либо сделать его вручную в текстовом редакторе и разместить в корневом каталоге (папка самого верхнего уровня на сервере), либо воспользоваться специальными плагинами для настройки файла.

Как создать robots.txt в Блокноте

Самый простой способ создать файл robots.txt — написать его в блокноте и загрузить на сервер в корневой каталог.

Лучше не использовать стандартное приложение — воспользуйтесь специальными редакторы текста, например, Notepad++ или Sublime Text, которые поддерживают сохранение файла в конкретной кодировке. Дело в том, что поисковые роботы, например, Яндекс и Google, читают только файлы в UTF-8 с определенными переносами строк — стандартный Блокнот Windows может добавлять ненужные символы или использовать неподдерживаемые переносы.

Дело в том, что поисковые роботы, например, Яндекс и Google, читают только файлы в UTF-8 с определенными переносами строк — стандартный Блокнот Windows может добавлять ненужные символы или использовать неподдерживаемые переносы.

Говорят, что это давно не так, но чтобы быть уверенным на 100%, используйте специализированные приложения.

Рассмотрим создание robots.txt на примере Sublime Text. Откройте редактор и создайте новый файл. Внесите туда нужные настройки, например:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://mysite.ru/sitemap.xmlГде mysite.ru — домен вашего сайта.

После того, как вы записали настройки, выберите в меню File ⟶ Save with Encoding… ⟶ UTF-8 (или Файл ⟶ Сохранить с кодировкой… ⟶ UTF-8).

Назовите файл “robots.txt” (обязательно с маленькой буквы).

Файл готов к загрузке.

Загрузить robots.txt через FTP

Для того, чтобы загрузить созданный robots.txt на сервер через FTP, нужно для начала включить доступ через FTP в настройках хостинга.

После этого скопируйте настройки доступа по FTP: сервер, порт, IP-адрес, логин и пароль (не совпадают с логином и паролем для доступа на хостинг, будьте внимательны!).

Чтобы загрузить файл robots.txt вы можете воспользоваться специальным файловым менеджером, например, FileZilla или WinSCP, или же сделать это просто в стандартном Проводнике Windows. Введите в поле поиска “ftp://адрес_FTP_сервера”.

После этого Проводник попросит вас ввести логин и пароль.

Введите данные, которые вы получили от хостинг-провайдера на странице настроек доступа FTP. После этого в Проводнике откроются файлы и папки, расположенные на сервере. Скопируйте файл robots.txt в корневую папку. Готово.

Загрузить или создать robots.txt на хостинге

Если у вас уже есть готовый файл robots. txt, вы можете просто загрузить его на хостинг. Зайдите в файловый менеджер панели управления вашим хостингом, нажмите на кнопку «Загрузить» и следуйте инструкциям (подробности можно узнать в поддержке у вашего хостера.

txt, вы можете просто загрузить его на хостинг. Зайдите в файловый менеджер панели управления вашим хостингом, нажмите на кнопку «Загрузить» и следуйте инструкциям (подробности можно узнать в поддержке у вашего хостера.

Многие хостинги позволяют создавать текстовые файлы прямо в панели управления хостингом. Для этого нажмите на кнопку «Создать файл» и назовите его “robots.txt” (с маленькой буквы).

После этого откройте его во встроенном текстовом редакторе хостера. Если вам предложит выбрать кодировку для открытия файла — выбирайте UTF-8.

Добавьте нужные директивы и сохраните изменения.

Плагины для редактирования robots.txt

Гораздо проще внести нужные директивы в robots.txt с помощью специальных плагинов для редактирования прямо из панели управления WordPress. Самые популярные из них — ClearfyPro, Yoast SEO и All in One SEO Pack.

Clearfy Pro

Этот плагин отлично подходит для начинающих: даже если вы ничего не понимаете в SEO, Clearfy сам создаст правильный и валидный файл robots.txt. Кроме этого, плагин предлагает пошаговую настройку самых важных для поисковой оптимизации функций, так что на первых этапах развития сайта этого будет достаточно.

Чтобы настроить robots.txt, в панели управления WordPress перейдите в пункт Настройки ⟶ Clearfy ⟶ SEO.

Переключите «Создайте правильный robots.txt» в положение «Вкл». Clearfy отобразит правильные настройки файла robots.txt. Вы можете дополнить эти настройки, например, запретив поисковым роботам индексировать папку /wp-admin/.

После внесения настроек нажмите на кнопку «Сохранить» в верхнем правом углу.

Yoast SEO

Плагин Yoast SEO хорош тем, что в нем есть много настроек для поисковой оптимизации: он напоминает использовать ключевые слова на странице, помогает настроить шаблоны мета-тегов и предлагает использовать мета-теги Open Graph для социальных сетей.

С его помощью можно отредактировать и robots.txt.

Для этого зайдите в раздел Yoast SEO ⟶ Инструменты ⟶ Редактор файлов.

Здесь вы сможете отредактировать robots.txt и сохранить его, не заходя на хостинг. По умолчанию Yoast SEO не предлагает никаких настроек для файла, так что его придется прописать вручную.

После изменений нажмите на кнопку «Сохранить изменения в robots.txt».

All in One SEO Pack

Еще один мощный плагин для управления SEO на WordPress. Чтобы отредактировать robots.txt через All in One SEO Pack, сначала придется активировать специальный модуль. Для этого перейдите на страницу плагина в раздел «Модули» и нажмите «Активировать» на модуле «robots.txt».

После подключения модуля перейдите на его страницу. С помощью него можно разрешать или запрещать для обработки конкретные страницы и группы страниц для разных поисковых роботов, не прописывая директивы вручную.

Правильный и актуальный robots.txt в 2020 году

Для того, чтобы создать правильный файл robots.txt, нужно знать, что означает каждая из директив в файле, записать их в правильном порядке и проверить файл на валидность.

Что означают указания в файле robots.txt?

User-agent — поисковой робот

В строке User-agent указывается, для каких роботов написаны следующие за этой строкой указания. Например, если вы хотите запретить индексацию сайта для поисковых роботов Bing, но разрешить для Google и Яндекс, это будет выглядеть примерно так:

| User-agent: Googlebot Disallow: User-agent: Yandex User-agent: Bingbot | Для робота Google Запретить: ничего Для робота Яндекс Для робота Bing |

На практике необходимость разграничивать указания для разных поисковых роботов встречается довольно редко. Гораздо чаще robots.txt пишут для всех роботов сразу. Это указывается через звездочку:

Гораздо чаще robots.txt пишут для всех роботов сразу. Это указывается через звездочку:

User-agent: *У поисковых систем есть и специальные роботы — например, бот YandexImages обходит изображения, чтобы выдавать их в поиске Яндекса по картинкам, а Googlebot-News собирает информацию для выдаче в Google Новостях. Полные списки ботов можно найти в справке поисковых систем — введите в поиск «поисковые роботы [название ПС]».

Disallow

Эта директива сообщает поисковым роботам, что страница или целый список страниц запрещены для обхода. Важно понимать, что указание в robots.txt не гарантирует, что страница не попадет в выдачу — если ссылка на запрещенную в файле страницу встречается на разрешенных страницах сайта, поисковик все равно может включить его в индекс.

Если вы хотите разрешить поисковым роботам обрабатывать все страницы сайта, оставьте это указание пустым.

User-agent: *

Disallow:Если вам нужно запретить для индексации несколько страниц или директорий, указывайте каждую из них отдельно:

User-agent: *

Disallow: /wp-admin/

Disallow: /dev/

Disallow: /index2.htmlAllow

Это указание разрешает ботам поисковиков сканировать определенные страницы. Обычно это используют, когда нужно закрыть целую директорию, но разрешить обрабатывать часть страниц.

User-agent: *

Disallow: /wp-admin/

Disallow: /dev/

Allow: /dev/index.phpБольшинство поисковых систем обрабатывают в первую очередь более точные правила (например, с указанием конкретных страниц), а затем — более широкие. Например:

User-agent: *

Disallow: /wp-admin/

Disallow: /dev/

Allow: /dev/index.phpТакой файл robots.txt укажет роботам, что не нужно сканировать все страницы из папки «catalog», кроме «best-offers. html».

html».

Host

Указание host говорит поисковым роботам, какое из зеркал сайта является главным. Например, если сайт работает через защищенный протокол https, в robots.txt стоит это указать:

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ruЭта директива уже устарела, и сегодня ее использовать не нужно. Если она есть в вашем файле сейчас, лучше ее удалить — есть мнение, что она может негативно сказываться на продвижении.

Sitemap

Этот атрибут — еще один способ указать поисковым роботам, где находится карта сайта. Она нужна для того, чтобы поисковик смог добраться до любой страницы сайта в один клик вне зависимости от сложности его структуры.

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ru

Sitemap: https://mysite.ru/sitemap.xmlCrawl-delay

Такой параметр помогает установить задержку для обработки сайта поисковыми роботами. Это может быть полезно, если сайт расположен на слабом сервере и вы не хотите, чтобы боты перегружали его запросами: передайте в crawl-delay время, которое должно проходить между запросами роботов. Время передается в секундах.

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ru

Sitemap: https://mysite.ru/sitemap.xml

Crawl-delay: 10На самом деле современные поисковые роботы и так делают небольшую задержку между запросами, так что прописывать это явно стоит только в том случае, если сервер очень слабый.

Clean-param

Эта настройка пригодится, чтобы скрыть из поиска страницы, в адресе которых есть параметры, не влияющие на ее содержание. Звучит сложно, так что объясняем на примере.

Допустим, на сайте есть категория «Смартфоны» и она расположена по адресу mysite.ru/catalog/smartphones.

У категории есть фильтры, которые передаются с помощью GET-запроса. Предположим, пользователь отметил в фильтре «Производитель: Apple, Samsung». Адрес страницы поменялся на

Предположим, пользователь отметил в фильтре «Производитель: Apple, Samsung». Адрес страницы поменялся на

mysite.ru/catalog/smartphones/?manufacturer=apple&manufacturer=samsung,

где ?manufacturer=apple&manufacturer=samsung — параметры, которые влияют на содержимое страницы. Логично, что такие страницы можно и нужно выводить в поиске — эту страницу со включенным фильтром можно продвигать по запросу вроде «смартфоны эппл и самсунг».

А теперь представим, что пользователь перешел в категорию «Смартфоны» по ссылке, которую вы оставили во ВКонтакте, добавив к ней UTM-метки, чтобы отследить, эффективно ли работает ваша группа.

mysite.ru/catalog/smartphones/?utm_source=vk&utm_medium=post&utm_campaign=sale

В такой ссылке параметры ?utm_source=vk&utm_medium=post&utm_campaign=sale не влияют на содержимое страницы — mysite.ru/catalog/smartphones/ и mysite.ru/catalog/smartphones/?utm_source=vk&utm_medium=post&utm_campaign=sale будут выглядеть одинаково.

Чтобы помочь поисковым роботам понять, на основании каких параметров содержимое меняется, а какие не влияют на контент страницы, и используется настройка Clean-param.

User-agent: *

Disallow: /wp-admin/

Host: https://mysite.ru

Sitemap: https://mysite.ru/sitemap.xml

Clean-param: utm_campaign /

Clean-param: utm_medium /

Clean-param: utm_source /С помощью такой директивы вы укажете поисковым роботам, что при обработке страниц для поисковой выдачи нужно удалять из ссылок такие параметры, как utm_campaign, utm_medium и utm_source.

Как проверить robots.txt

Для того, чтобы проверить валидность robots.txt, можно использовать инструменты вебмастера поисковых систем. Инструмент проверки robots. txt есть у Google в Search Console — для его использования понадобится авторизация в Google и подтверждение прав на сайт, для которого проверяется файл.

txt есть у Google в Search Console — для его использования понадобится авторизация в Google и подтверждение прав на сайт, для которого проверяется файл.

Похожий инструмент для проверки robots.txt есть и у Яндекса, и он даже удобнее, потому что не требует авторизации.

Эти приложения помогают понять, как поисковый робот видит файл: если какие-то из директив прописаны в нем неверно, инструмент проверки их проигнорирует либо предупредит о них.

Чего стоит избегать при настройке robots.txt?

Будьте внимательны: хоть robots.txt непосредственно и не влияет на то, окажется ли ваш сайт в выдаче, этот файл помогает избежать попадания в индекс тех страниц, которые должны быть скрыты от пользователей. Все, что робот не сможет интерпретировать, он проигнорирует.

Вот несколько частых ошибок, которые можно допустить при настройке.

Не указан User-Agent

Или указан после директивы, например:

Disallow: /wp-admin/

User-agent: *Такую директиву робот прочитает так:

Disallow: /wp-admin/— так, это не мне, не читаю

User-agent: * — а это мне… Дальше ничего? Отлично, обработаю все страницы!

Любые указания к поисковым роботам должны начинаться с директивы User-agent: название_бота.

User-agent: GoogleBot

Disallow: /wp-admin/

User-agent: Yandex

Disallow: /wp-admin/Или для всех сразу:

User-agent: *

Disallow: /wp-admin/Несколько папок в Disallow

Если вы укажете в директиве Disallow сразу несколько директорий, неизвестно, как робот это прочтет.

User-agent: *

Disallow: /wp-admin/ /catalog/ /temp/ /user/ — “/wp-admin/catalog/temp/user/”? “/catalog/ /user”? “??????”?По своему разумению он может обработать такую конструкцию как угодно. Чтобы этого не случилось, каждую новую директиву начинайте с нового Disallow:

Чтобы этого не случилось, каждую новую директиву начинайте с нового Disallow:

User-agent: *

Disallow: /wp-admin/

Disallow: /catalog/

Disallow: /temp/

Disallow: /user/Регистр в названии файла robots.txt

Поисковые роботы смогут прочитать только файл с названием “robots.txt”. “Robots.txt”, “ROBOTS.TXT” или “R0b0t.txt” они просто проигнорируют.

Резюме

- robots.txt — файл с рекомендациями, как обрабатывать страницы сайта, для поисковых роботов.

- В WordPress по умолчанию нет robots.txt, но есть виртуальный файл, который запрещает ботам сканировать страницы панели управления.

- Создать robots.txt можно в блокноте и загрузить его на хостинг в корневой каталог.

- Файл robots.txt должен быть создан в кодировке UTF-8.

- Проще создать robots.txt с помощью плагинов для WordPress — Clearfy Pro, Yoast SEO, All in One SEO Pack или других SEO-плагинов.

- С помощью robots.txt можно создать директивы для разных поисковых роботов, сообщить о главном зеркале сайта, передать адрес sitemap.xml или указать параметры URL-адресов, которые не влияют на содержимое страницы.

- Проверить валидность robots.txt можно с помощью инструментов от Google и Яндекс.

- Все директивы файла robots.txt, которые робот не сможет интерпретировать, он проигнорирует.

Правильный файл robots.txt для WordPress

👍 Научим создавать сайты на WordPress бесплатно за 19 уроков. Подробнее →

robots.txt является файлом, специально предназначенным для поисковых систем. В нем указывается, какие части сайта нужно выдавать в поиске, а какие нет. Важность robots.txt неоценима, так как он позволяет нацелить поисковую систему на попадание нужного контента сайта в выдаче результатов. Например, при запросе в Гугле “купить стиральную машину” конечному покупателю незачем попадать на страницу администрирования магазина. В этом случае несомненно важно будет пользователю перейти сразу в раздел “Стиральные машины”.

Как добавить robots.txt на сайт?

Если Вы используете плагин Clearfy Pro – просто выставьте галочку напротив Создать правильный robots.txt в разделе SEO на странице настроек плагина. Ничего вставлять из этой статьи Вам не нужно, все реализовано в плагине.

Добавить файл можно несколькими способами. Наиболее удобный для пользователя – по FTP. Для этого необходимо создать сам файл robots.txt. Затем, воспользовавшись одним из FTP-клиентов (например, FileZilla), загрузить robots.txt в корневую папку сайта (рядом с файлами wp-config.php, wp-settings.php) Следует отметить, что перед загрузкой файла нужно узнать у Вашей хостинг-компании IP-адрес, за которым закреплен Ваш сайт, имя FTP-пользователя и пароль.

После успешной загрузки robots.txt, перейдя по адресу http://sitename.com/robots.txt, Вы сможете посмотреть актуальное состояние файла.

Важным является тот факт, что, изменив файл robots.txt, вы не сразу заметите результаты. Для этого может понадобится от одного до нескольких месяцев (это зависит от поисковой системы). Правильным вариантом является составление корректного файла уже на стадии разработки сайта.

Пример корректного robots.txt

User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-json/ Disallow: /xmlrpc.php Disallow: /readme.html Disallow: /*? Disallow: /?s= Allow: /*.css Allow: /*.js Host: sitename.com

** Вместо sitename.com следует указать название Вашего сайта

Плагины для robots.txt

Для облегчения создания robots.txt в WordPress существуют специальные плагины. Некоторые из них: WordPress Robots.txt File, DL Robots.txt, Yoast SEO.

Рассмотрим создание файла robots.txt на примере одного из самых мощных SEO-плагинов Yoast SEO.

После установки и активации плагина необходимо в админ-панели выбрать пункт SEO->Консоль. На вкладке Возможности перейти в раздел Дополнительные настройки страницы, передвинуть ползунок в состояние Включено и сохранить изменения. В админ-панели появятся несколько дополнительных пунктов. Далее необходимо перейти по пункту SEO->Инструменты, где выбрать Редактор файлов. Далее на странице редактора необходимо нажать на кнопку Создать файл robots.txt, в редакторе вставить вышеописанный код и нажать Сохранить изменения в robots.txt.

В админ-панели появятся несколько дополнительных пунктов. Далее необходимо перейти по пункту SEO->Инструменты, где выбрать Редактор файлов. Далее на странице редактора необходимо нажать на кнопку Создать файл robots.txt, в редакторе вставить вышеописанный код и нажать Сохранить изменения в robots.txt.

Нажмите, пожалуйста, на одну из кнопок, чтобы узнать понравилась статья или нет.

Мне нравится1Не нравится1

Если Вам понравилась статья — поделитесь с друзьями

WordPress Руководство Robots.txt — что это такое и как его использовать

Вы когда-нибудь слышали термин robots.txt и задавались вопросом, как он применим к вашему веб-сайту? На большинстве веб-сайтов есть файл robots.txt, но это не значит, что большинство веб-мастеров его понимают. В этом посте мы надеемся изменить это, предложив более подробно изучить файл robots.txt WordPress, а также то, как он может контролировать и ограничивать доступ к вашему сайту. К концу вы сможете ответить на такие вопросы, как:

Есть много чего рассказать, так что приступим!

Что такое роботы WordPress.текст?

Прежде чем мы сможем говорить о файле robots.txt WordPress, важно определить, что в данном случае представляет собой «робот». Роботы — это любой тип «ботов», который посещает веб-сайты в Интернете. Самый распространенный пример — сканеры поисковых систем. Эти боты «ползают» по сети, чтобы помочь поисковым системам, таким как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Итак, боты есть, вообще , вещь для интернета хорошая… или хотя бы необходимая вещь. Но это не обязательно означает, что вы или другие веб-мастера хотите, чтобы боты работали без ограничений.Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию в середине 1990-х годов стандарта исключения роботов . Robots.txt — это практическая реализация этого стандарта — , он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом. . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

. Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Эта «участвующая» часть, тем не менее, важна. Robots.txt не может заставить бота следовать его директивам.А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют некоторые команды , которые вы можете поместить в Robots.txt. Например, Google проигнорирует любые правила, которые вы добавляете в свой robots.txt, о том, как часто его сканеры посещают. Если у вас много проблем с ботами, вам может пригодиться такое решение безопасности, как Cloudflare или Sucuri.

Почему вам следует заботиться о своем файле Robots.txt?

Для большинства веб-мастеров преимущества хорошо структурированного файла robots.txt можно разделить на две категории:

- Оптимизация ресурсов сканирования поисковых систем путем указания им не тратить время на страницы, которые вы не хотите индексировать. Это помогает гарантировать, что поисковые системы сосредоточатся на сканировании наиболее важных для вас страниц.

- Оптимизация использования вашего сервера за счет блокировки ботов, тратящих ресурсы впустую.

Robots.txt конкретно не о контроле того, какие страницы индексируются в поисковых системах

Robots.txt — не надежный способ контролировать, какие страницы индексируются поисковыми системами.Если ваша основная цель — предотвратить включение определенных страниц в результаты поисковой системы, правильный подход — использовать метатег noindex или другой аналогичный прямой метод.

Это связано с тем, что ваш Robots.txt напрямую не говорит поисковым системам не индексировать контент — он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, сам Google заявляет, что если внешний сайт ссылается на страницу, которую вы исключаете с помощью файла Robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что, если на странице есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, все равно может проиндексироваться. Вот что он сказал на видеовстрече в Центре веб-мастеров:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы файлом robots.txt, то теоретически может случиться так, что кто-то случайно перейдет по ссылке на одну из этих страниц. И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован роботами.текст. Таким образом, мы не узнаем, что вы не хотите, чтобы эти страницы действительно индексировались.

Если они не заблокированы файлом robots.txt, вы можете поместить на эти страницы метатег noindex. И если кто-нибудь будет ссылаться на них, и мы просканируем эту ссылку и подумаем, что, может быть, здесь есть что-то полезное, тогда мы будем знать, что эти страницы не нужно индексировать, и мы можем просто полностью пропустить их из индексации.

Итак, в связи с этим, если у вас есть что-то на этих страницах, что вы не хотите индексировать, не запрещайте их, вместо этого используйте noindex .

Как создать и отредактировать файл WordPress Robots.txt

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Поэтому, даже если вы и пальцем не пошевелите, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец своего доменного имени. Например, «https://kinsta.com/robots.txt» вызывает файл robots.txt, который мы используем здесь, в Kinsta:

Пример файла Robots.txt

Поскольку этот файл виртуальный, вы не можете его редактировать.Если вы хотите отредактировать файл robots.txt, вам нужно будет фактически создать на своем сервере физический файл, которым вы можете манипулировать по мере необходимости. Вот три простых способа сделать это…

Вот три простых способа сделать это…

Как создать и отредактировать файл Robots.txt с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (а позже отредактировать) файл robots.txt прямо из интерфейса Yoast. Однако, прежде чем вы сможете получить к нему доступ, вам необходимо включить расширенные функции Yoast SEO, перейдя в SEO → Dashboard → Features и переключившись на страницы дополнительных настроек :

Как включить расширенные функции Yoast

После активации перейдите в SEO → Инструменты и нажмите Редактор файлов :

Как получить доступ к редактору файлов Yoast

Если у вас еще нет физического робота.txt, Yoast предоставит вам возможность Создать файл robots.txt :

Как создать Robots.txt в Yoast

И как только вы нажмете эту кнопку, вы сможете редактировать содержимое файла Robots.txt прямо из того же интерфейса:

Как редактировать Robots.txt в Yoast

По мере чтения мы подробнее рассмотрим, какие типы директив следует добавлять в файл robots.txt WordPress.

Как создать и отредактировать файл Robots.txt с помощью All In One SEO

Если вы используете почти такой же популярный плагин, как Yoast All in One SEO Pack , вы также можете создавать и редактировать свои роботы WordPress.txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All in One SEO → Feature Manager и Активировать в файле Robots.txt feature:

Как создать Robots.txt в All In One SEO

Затем вы сможете управлять своим файлом Robots.txt, перейдя в All in One SEO → Robots.txt:

Как редактировать Robots.txt в All In One SEO

Как создать и отредактировать файл Robots.txt через FTP

Если вы не используете плагин SEO, который предлагает robots. txt, вы по-прежнему можете создавать файл robots.txt и управлять им через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

txt, вы по-прежнему можете создавать файл robots.txt и управлять им через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

.

Как создать свой собственный файл Robots.txt

Затем подключитесь к своему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. Вы можете внести дополнительные изменения в свой файл robots.txt, отредактировав его через SFTP или загрузив новые версии файла.

Что помещать в файл robots.txt

Хорошо, теперь у вас есть физический робот.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле делаете с этим файлом? Как вы узнали из первого раздела, robots.txt позволяет вам контролировать взаимодействие роботов с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent — позволяет настраивать таргетинг на определенных ботов. Пользовательские агенты — это то, что боты используют для идентификации себя. С их помощью вы можете, например, создать правило, которое применяется к Bing, но не к Google.

- Запретить — позволяет запретить роботам доступ к определенным областям вашего сайта.

Существует также команда Allow , которую вы будете использовать в нишевых ситуациях. По умолчанию все на вашем сайте помечено как Allow , поэтому нет необходимости использовать команду Allow в 99% случаев. Но он пригодится там, где вы хотите Запретить доступ к папке и ее дочерним папкам, но Разрешить доступ к одной конкретной дочерней папке.

Вы добавляете правила, сначала указывая, к какому User-agent должно применяться правило, а затем перечисляя, какие правила применять, используя Disallow и Allow .Есть также некоторые другие команды, такие как Crawl-delay и Sitemap , но это либо:

- Игнорируется большинством основных поисковых роботов или интерпретируется совершенно по-разному (в случае задержки сканирования)

- Изменилось с помощью таких инструментов, как Google Search Console (для карт сайта)

Давайте рассмотрим некоторые конкретные варианты использования, чтобы показать вам, как все это сочетается.

Как использовать Robots.txt для блокировки доступа ко всему сайту

Допустим, вы хотите заблокировать всем поисковым роботам доступ к вашему сайту.Это маловероятно на действующем сайте, но может пригодиться для сайта разработки. Для этого вы должны добавить этот код в свой файл robots.txt WordPress:

Агент пользователя: *

Disallow: / Что происходит в этом коде?

Звездочка * рядом с User-agent означает «все пользовательские агенты». Звездочка — это подстановочный знак, означающий, что он применяется к каждому пользовательскому агенту. / косая черта рядом с Disallow означает, что вы хотите запретить доступ к всем страницам , которые содержат «yourdomain.com / »(т.е. каждая страница вашего сайта).

Как использовать Robots.txt, чтобы заблокировать доступ одного бота к вашему сайту

Давайте изменим ситуацию. В этом примере мы сделаем вид, что вам не нравится, что Bing сканирует ваши страницы. Вы все время работаете в команде Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать сканирование вашего сайта только Bing, замените подстановочный знак * звездочку на Bingbot:

Подпишитесь на информационный бюллетень

Мы увеличили наш трафик на 1187% с помощью WordPress.

Присоединяйтесь к более чем 20 000 других людей, которые получают нашу еженедельную рассылку с инсайдерскими советами по WordPress!

Подпишись сейчас

Агент пользователя: Bingbot

Disallow: / По сути, приведенный выше код говорит только применить правило Disallow к ботам с пользовательским агентом «Bingbot» . Вы вряд ли захотите блокировать доступ к Bing, но этот сценарий действительно пригодится, если есть конкретный бот, которому вы не хотите получать доступ к своему сайту. На этом сайте есть хороший список известных имен User-agent большинства сервисов.

На этом сайте есть хороший список известных имен User-agent большинства сервисов.

Как использовать Robots.txt для блокировки доступа к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и всем подпапкам этой папки). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Вся папка wp-admin

- wp-login.php

Вы можете использовать следующие команды:

Агент пользователя: *

Запретить: / wp-admin /

Запретить: / wp-login.php Как использовать Robots.txt для разрешения доступа к определенному файлу в запрещенной папке

Хорошо, теперь допустим, что вы хотите заблокировать всю папку, но все же хотите разрешить доступ к определенному файлу внутри этой папки. Здесь вам пригодится команда Allow . И это действительно очень применимо к WordPress. Фактически, виртуальный файл robots.txt WordPress прекрасно иллюстрирует этот пример:

Агент пользователя: *

Запретить: / wp-admin /

Разрешить: / wp-admin / admin-ajax.php Этот фрагмент блокирует доступ ко всей папке / wp-admin / , за исключением файла /wp-admin/admin-ajax.php .

Как использовать Robots.txt, чтобы запретить ботам сканировать результаты поиска WordPress

Одна специальная настройка WordPress, которую вы, возможно, захотите сделать, — это запретить поисковым роботам сканировать ваши страницы результатов поиска. По умолчанию WordPress использует параметр запроса «? S =». Итак, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

Агент пользователя: *

Запретить: /? S =

Disallow: / search / Это также может быть эффективным способом остановить мягкие ошибки 404, если вы их получаете.Обязательно прочтите наше подробное руководство о том, как ускорить поиск в WordPress.

Как создать разные правила для разных ботов в robots.txt

До сих пор все примеры касались одного правила за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в объявление User-agent для каждого бота. Например, если вы хотите создать одно правило, которое применяется к , все боты , а другое правило, которое применяется к , только Bingbot , вы можете сделать это так:

Агент пользователя: *

Запретить: / wp-admin /

Пользовательский агент: Bingbot

Disallow: / В этом примере для всем ботам будет заблокирован доступ к / wp-admin /, а для Bingbot будет заблокирован доступ ко всему вашему сайту.

Тестирование файла Robots.txt

Вы можете протестировать свой файл robots.txt WordPress в Google Search Console, чтобы убедиться, что он правильно настроен. Просто нажмите на свой сайт и в разделе «Сканирование» нажмите «Тестер robots.txt». Затем вы можете отправить любой URL, включая вашу домашнюю страницу. Вы должны увидеть зеленый Разрешено , если все доступно для сканирования. Вы также можете проверить URL-адреса, которые вы заблокировали, чтобы убедиться, что они действительно заблокированы, или Disallowed .

Тестовый файл robots.txt

Остерегайтесь спецификации UTF-8

BOM обозначает знак порядка байтов и, по сути, является невидимым символом, который иногда добавляется к файлам старыми текстовыми редакторами и т.п.Если это произойдет с вашим файлом robots.txt, Google может неправильно его прочитать. Вот почему так важно проверять файл на наличие ошибок. Например, как показано ниже, в нашем файле был невидимый символ, и Google жалуется на непонятный синтаксис. Это по существу делает недействительной первую строку нашего файла robots.txt, что не очень хорошо! У Гленна Гейба есть отличная статья о том, как бомба UTF-8 может убить вашего SEO.

Спецификация UTF-8 в вашем файле robots.txt

Робот Googlebot в основном базируется в США

Также важно не блокировать робота Googlebot из США, даже если вы нацеливаетесь на регион за пределами США.Иногда они выполняют локальное сканирование, но Googlebot в основном находится в США .

Робот Googlebot в основном находится в США, но иногда мы также выполняем локальное сканирование. https://t.co/9KnmN4yXpe

— Центр поиска Google (@googlesearchc) 13 ноября 2017 г.

Что популярные сайты WordPress помещают в свой файл Robots.txt

Чтобы на самом деле предоставить некоторый контекст для пунктов, перечисленных выше, вот как некоторые из самых популярных сайтов WordPress используют своих роботов.txt файлы.

TechCrunch

TechCrunch Файл Robots.txt

Помимо ограничения доступа к ряду уникальных страниц, TechCrunch, в частности, запрещает поисковым роботам:

Еще они установили особые ограничения для двух ботов:

Если вам интересно, IRLbot — это сканер из исследовательского проекта Техасского университета A&M. Это странно!

Фонд Обамы

Файл Robots.txt Фонда Обамы

Фонд Обамы не делал никаких специальных дополнений, ограничивая доступ исключительно к / wp-admin /.

Злые птицы

Angry Birds Файл Robots.txt

Angry Birds имеет те же настройки по умолчанию, что и The Obama Foundation. Ничего особенного не добавлено.

Дрифт

Файл Drift Robots.txt

Наконец, Drift решает определить свои карты сайта в файле Robots.txt, но в остальном оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Правильно используйте Robots.txt

Завершая наше руководство по robots.txt, мы хотим еще раз напомнить вам, что использование команды Disallow в вашем файле robots. txt — это не то же самое, что использовать тег noindex . Robots.txt блокирует сканирование, но не обязательно индексацию. Вы можете использовать его для добавления определенных правил, определяющих, как поисковые системы и другие боты взаимодействуют с вашим сайтом, но он не будет явно контролировать, индексируется ваш контент или нет.

txt — это не то же самое, что использовать тег noindex . Robots.txt блокирует сканирование, но не обязательно индексацию. Вы можете использовать его для добавления определенных правил, определяющих, как поисковые системы и другие боты взаимодействуют с вашим сайтом, но он не будет явно контролировать, индексируется ваш контент или нет.

Для большинства обычных пользователей WordPress нет необходимости срочно изменять виртуальный файл robots.txt по умолчанию. Но если у вас возникли проблемы с конкретным ботом или вы хотите изменить способ взаимодействия поисковых систем с определенным плагином или темой, которую вы используете, вы можете добавить свои собственные правила.

Мы надеемся, что вам понравилось это руководство, и обязательно оставьте комментарий, если у вас возникнут дополнительные вопросы об использовании файла robots.txt в WordPress.

Если вам понравилась эта статья, то вам понравится хостинговая платформа Kinsta WordPress. Ускорьте свой сайт и получите круглосуточную поддержку от нашей опытной команды WordPress. Наша инфраструктура на базе Google Cloud ориентирована на автоматическое масштабирование, производительность и безопасность. Позвольте нам показать вам разницу в Kinsta! Ознакомьтесь с нашими тарифами

Полное руководство по роботам WordPress.txt (и как его использовать для SEO)

WordPress

время доступа

21 февраля 2021 г.

песочные часы пустые

7 мин чтения

Чтобы обеспечить высокий рейтинг вашего сайта на страницах результатов поисковых систем (SERP), вам необходимо упростить для «роботов» поисковых систем возможность исследования его наиболее важных страниц. Наличие хорошо структурированного файла robots.txt поможет направить этих ботов на страницы, которые вы хотите проиндексировать (и избежать остальных).

В этой статье мы рассмотрим:

- Что такое файл robots.txt и почему он важен

- Где находится файл robots.

txt WordPress .

txt WordPress . - Как создать файл robots.txt .

- Какие правила включить в файл robots.txt WordPress .

- Как протестировать файл robots.txt и отправить его в Google Search Console.

К концу нашего обсуждения у вас будет все необходимое для настройки идеального робота .txt для вашего сайта WordPress. Давайте нырнем!

Что такое файл robots.txt

WordPress (и зачем он вам нужен) Стандартный файл robots.txt

Когда вы создаете новый веб-сайт, поисковые системы будут отправлять своих миньонов (или ботов), чтобы они «пролезли» по нему и составили карту всех содержащихся на нем страниц. Таким образом, они будут знать, какие страницы отображать в качестве результатов, когда кто-то ищет похожие ключевые слова.На базовом уровне это достаточно просто.

Проблема в том, что современные веб-сайты содержат на намного больше элементов, чем просто страницы. WordPress позволяет вам, например, устанавливать плагины, которые часто имеют свои собственные каталоги. Однако вы не хотите, чтобы они отображались в результатах вашей поисковой системы, поскольку это нерелевантный контент.

Файл robots.txt предоставляет набор инструкций для роботов поисковых систем. Он говорит им: «Эй, вы можете посмотреть сюда, но не заходите в те комнаты там!» Этот файл может быть сколь угодно подробным, и его довольно легко создать, даже если вы не технический мастер.

На практике поисковые системы все равно будут сканировать ваш веб-сайт, даже если у вас не настроен файл robots.txt . Однако не создавать его неэффективно. Без этого файла вы предоставляете ботам индексировать весь ваш контент, и они настолько тщательны, что могут в конечном итоге показать те части вашего веб-сайта, к которым вы не хотите, чтобы другие люди имели доступ.

Что еще более важно, без файла robots.txt у вас будет много ботов, которые будут сканировать весь ваш сайт.Это может отрицательно сказаться на его производительности. Даже если попадание незначительно, скорость страницы всегда должна быть в верхней части вашего списка приоритетов. В конце концов, есть несколько вещей, которые люди ненавидят так же сильно, как медленные веб-сайты (в том числе и мы!).

Где находится файл robots.txt WordPress

Когда вы создаете веб-сайт WordPress, он автоматически создает виртуальный файл robots.txt , расположенный в основной папке вашего сервера. Например, если ваш сайт расположен по адресу yourfakewebsite.com , вы сможете посетить адрес yourfakewebsite.com/robots.txt, и увидеть такой файл:

Агент пользователя: * Запретить: / wp-admin / Disallow: / wp-includes /

Это пример очень простого файла robots.txt . Проще говоря, часть сразу после User-agent: объявляет, к каким ботам применяются приведенные ниже правила. Звездочка означает, что правила универсальны и применимы ко всем ботам. В этом случае файл сообщает этим ботам, что они не могут войти в ваши каталоги wp-admin и wp-includes .В этом есть определенный смысл, поскольку эти две папки содержат много конфиденциальных файлов.

Однако вы можете захотеть добавить больше правил в свой собственный файл. Прежде чем вы сможете это сделать, вам нужно понять, что это виртуальный файл . Обычно расположение robots.txt WordPress находится в корневом каталоге , который часто называется public_html или www (или назван в честь вашего веб-сайта):

Однако файл robots.txt , созданный WordPress по умолчанию, вообще недоступен из любого каталога. Он работает, но если вы хотите внести в него изменения, вам нужно будет создать собственный файл и загрузить его в корневую папку в качестве замены.

Мы рассмотрим несколько способов создания нового файла robots.txt для WordPress за минуту. А пока давайте поговорим о том, как определить, какие правила следует включать в ваши.

Какие правила включить в ваш WordPress

robots.txt Файл

В последнем разделе вы видели пример сгенерированного WordPress файла robots.txt . Он включал только два коротких правила, но большинство веб-сайтов устанавливали больше. Давайте взглянем на два разных файла robots.txt и и поговорим о том, что каждый из них делает по-своему.

Вот наш первый WordPress robots.txt , пример:

Агент пользователя: * Разрешать: / # Запрещенные подкаталоги Disallow: / checkout / Запретить: / images / Disallow: / forum /

Это общий роботов.txt для сайта с форумом. Поисковые системы часто индексируют каждую ветку форума. Однако в зависимости от того, для чего предназначен ваш форум, вы можете запретить его. Таким образом, Google не будет индексировать сотни сообщений о пользователях, которые ведут светскую беседу. Вы также можете установить правила, указывающие на определенные подфорумы, которых следует избегать, и позволить поисковым системам сканировать остальные из них.

Вы также заметите строку с надписью Allow: / в верхней части файла. Эта строка сообщает ботам, что они могут сканировать все страницы вашего веб-сайта, за исключением исключений, которые вы установили ниже.Точно так же вы заметите, что мы установили эти правила как универсальные (со звездочкой), как это делает виртуальный файл robots.txt WordPress.

Теперь давайте посмотрим на другой пример файла robots.txt WordPress :

.

Агент пользователя: * Запретить: / wp-admin / Запретить: / wp-includes / Пользовательский агент: Bingbot Disallow: /

В этом файле мы устанавливаем те же правила, что и WordPress по умолчанию. Однако мы также добавили новый набор правил, которые не позволяют поисковому роботу Bing сканировать наш веб-сайт.Bingbot, как вы могли догадаться, — это имя этого бота.

Однако мы также добавили новый набор правил, которые не позволяют поисковому роботу Bing сканировать наш веб-сайт.Bingbot, как вы могли догадаться, — это имя этого бота.

Вы можете довольно точно определить, какие роботы поисковых систем получают доступ к вашему сайту, а какие нет. На практике, конечно, Bingbot довольно безобиден (даже если он не такой крутой, как Googlebot). Однако есть — это вредоносных ботов.

Плохая новость в том, что они не всегда следуют инструкциям вашего файла robots.txt (в конце концов, они бунтовщики). Следует иметь в виду, что, хотя большинство ботов будут следовать инструкциям, которые вы предоставили в этом файле, вы не заставляете их делать это.Вы просто вежливо просите.

Если вы прочтете эту тему, вы найдете множество предложений о том, что разрешить и что заблокировать на своем веб-сайте WordPress. Однако, по нашему опыту, чем меньше правил, тем лучше. Вот пример того, как должен выглядеть ваш первый файл robots.txt :

User-Agent: * Разрешить: / wp-content / uploads / Запретить: / wp-content / plugins /

Традиционно WordPress любит блокировать доступ к каталогам wp-admin и wp-includes .Однако это больше не считается оптимальной практикой. Кроме того, если вы добавляете метаданные к изображениям в целях поисковой оптимизации (SEO), не имеет смысла запрещать ботам сканировать эту информацию. Вместо этого два приведенных выше правила охватывают то, что требуется для большинства основных сайтов.

Однако то, что вы включите в файл robots.txt , будет зависеть от вашего конкретного сайта и потребностей. Так что не стесняйтесь проводить дополнительные исследования самостоятельно!